AI 落地难?MCP 或许就是那把「关键钥匙」!

你是否也觉得,现在的大语言模型(LLM)虽然聪明,但在真正融入我们日常工作流时,总感觉还差那么点意思?它们就像知识渊博的“通才”,却难以触及你私有的数据宝库,也无法轻松搞定那些需要“动手”的具体操作。

别急,可能我们正在迎来破局点!今天,我们就来聊聊一个近来热度飙升的开放协议——MCP(Model Context Protocol,模型上下文协议)。这个由 Anthropic 在 2024 年底悄悄推出的协议,正从最初的默默无闻,逐渐显露出成为行业标准的巨大潜力。

那么,MCP 究竟是何方神圣?它又将如何改变我们与 AI 的协作方式?坐稳了,3 分钟带你快速掌握 MCP 的核心精髓!

AI 那么强,为啥还需要 MCP?

我们知道,像 GPT-4o、Claude 3.5 Sonnet 这样的 LLM,肚子里装满了海量的通用知识。但它们天生就有两个“够不着”的地方:

- 你的专属领地,它进不去:比如你数据库里的订单、笔记应用里的私密想法,或是电脑里的 Excel 表格,这些 LLM 默认是无法访问的。

- 外面的世界,它看不到:如果没联网,LLM 就成了“信息盲盒”,不知道当前的股价、最新的财报、明天的天气,更别提前沿科技动态了。

不仅如此,LLM 的“主业”是理解和生成文本,让它们直接帮你充话费、订机票,或者处理图片、算复杂的数列,多少有点“赶鸭子上架”,并非它们的核心优势。 这时候,MCP 就登场了!简单来说,MCP 就是一套标准化的“沟通规则”,它定义了一组外部工具,让 LLM 能够借助这些工具,“看到”它原本看不到的信息,“做到”它原本做不到的事情。 这背后的思路,其实是计算机领域的经典智慧:没有什么问题是加一层解决不了的。如果有,那就再加一层!MCP 就是为 LLM 能力扩展而生的那一层。

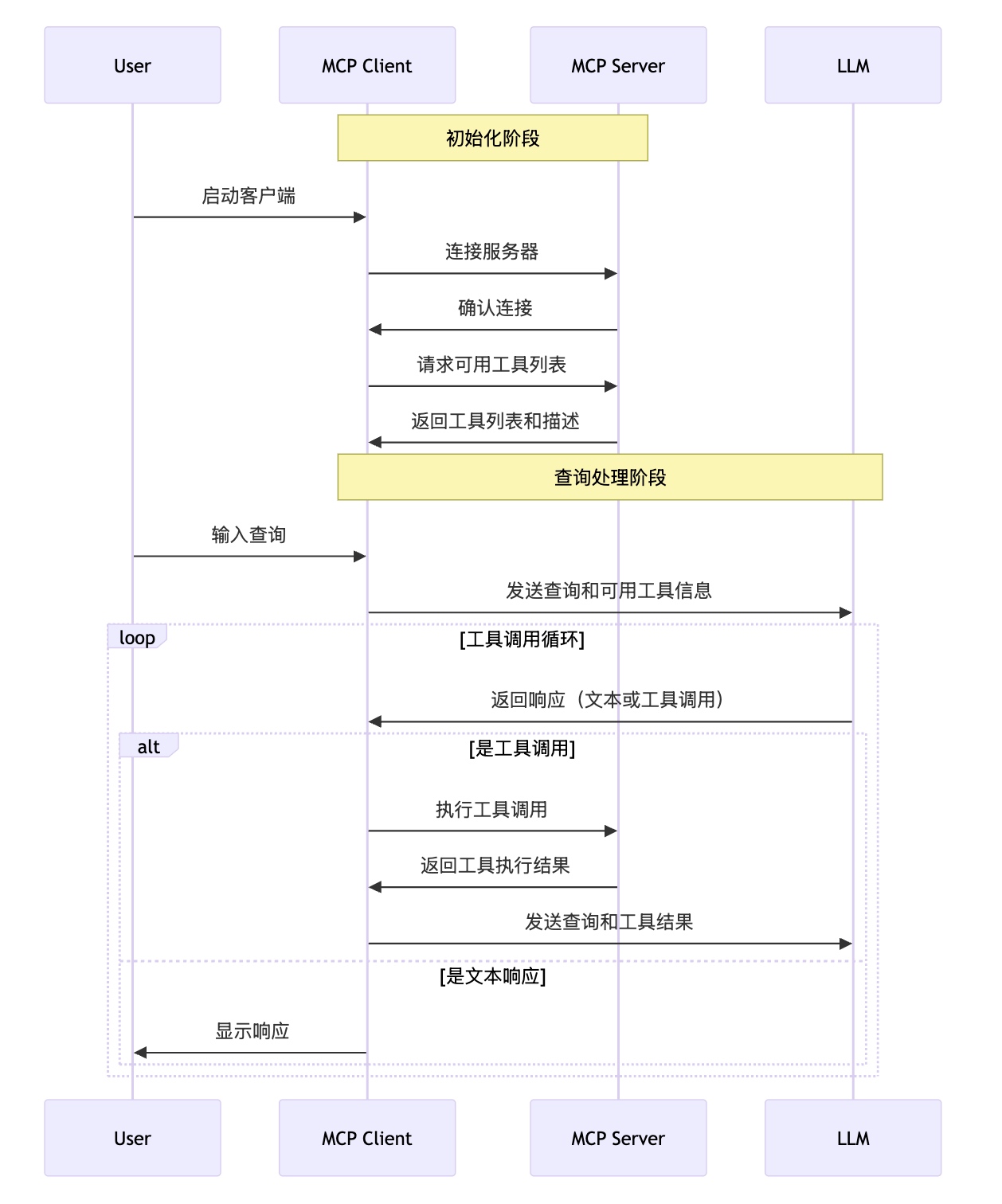

💡 MCP 到底是怎么工作的?一张图看懂!

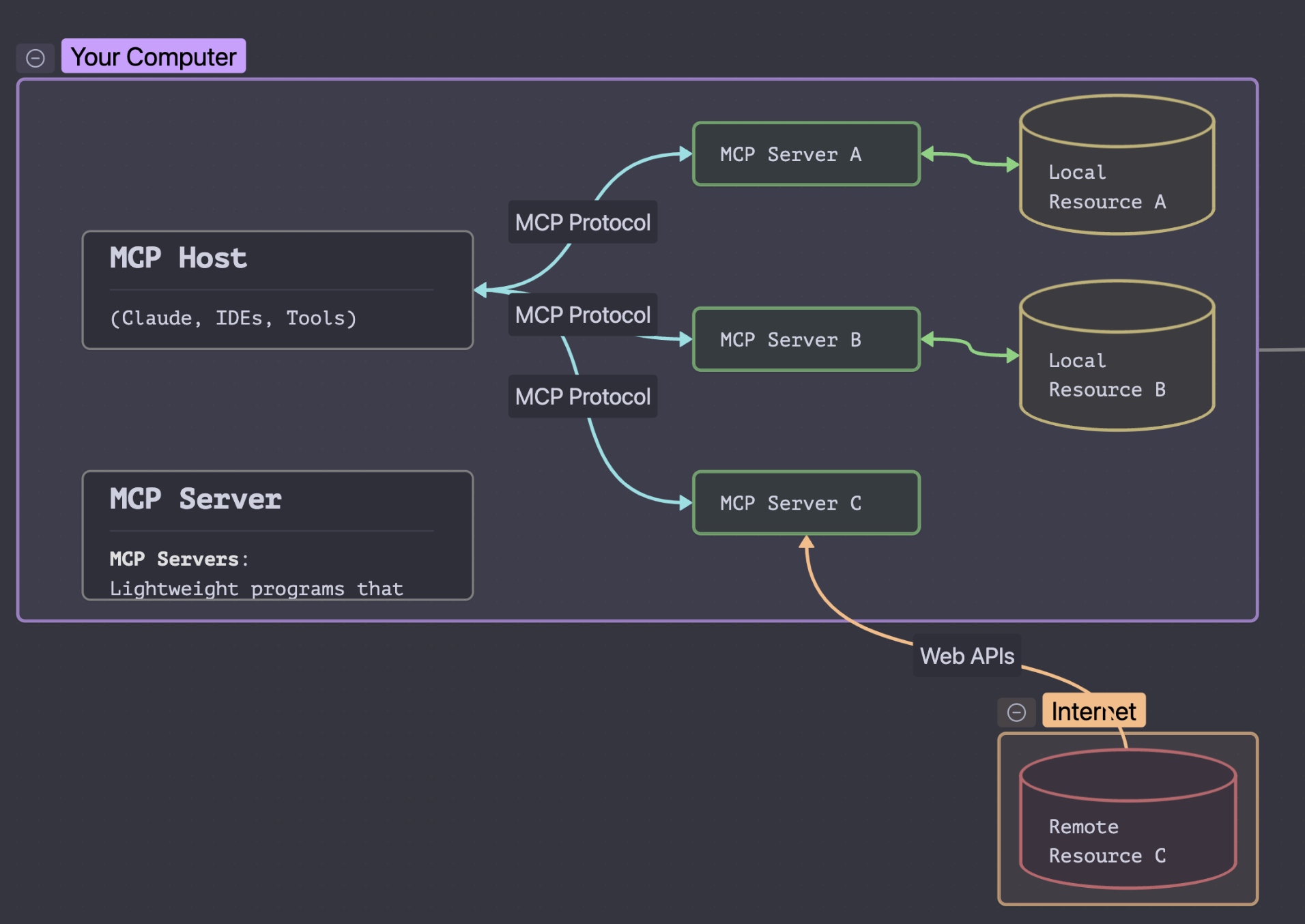

听起来有点抽象?别担心,MCP 的官方网站 () 给我们画了一张清晰的架构图:

要理解 MCP 的运作,我们需要认识三个关键角色:

要理解 MCP 的运作,我们需要认识三个关键角色:

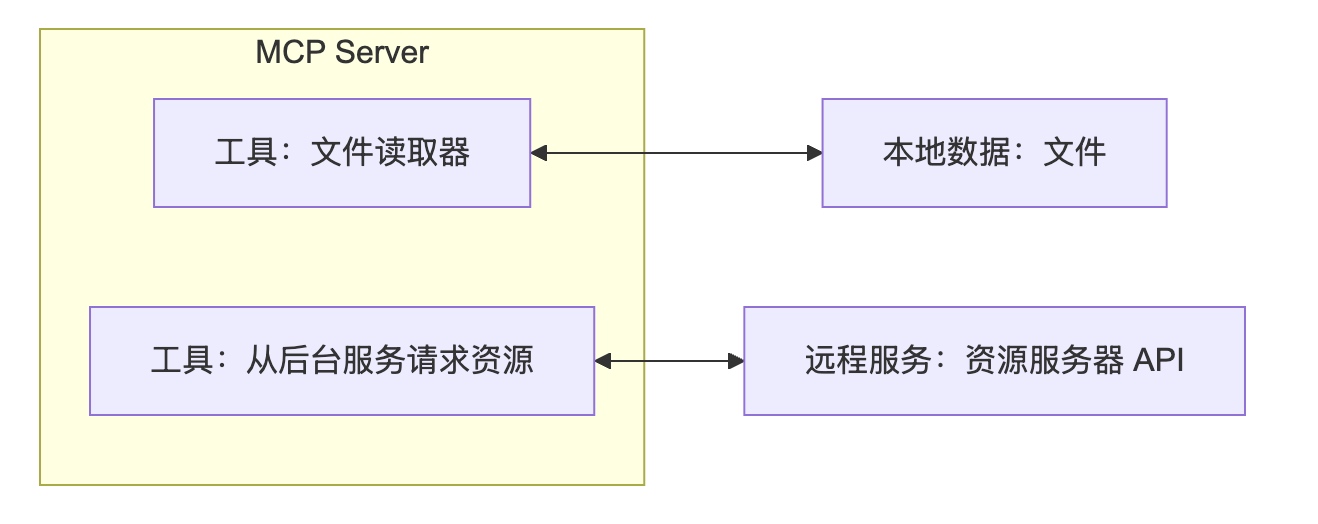

1. MCP 服务器 (The Muscle💪)

你可以把它想象成一个“工具箱”程序。这个程序里装着各种能帮 LLM 干活的工具和数据接口。它可以运行在你的本地电脑上(保护隐私),也可以部署在远程服务器。每个 MCP 服务器都提供特定的“技能”,比如从本地文件或远程服务(如数据库、API)获取信息。当 LLM 判断需要某个工具帮忙时,就会召唤对应的 MCP 服务器来执行任务。

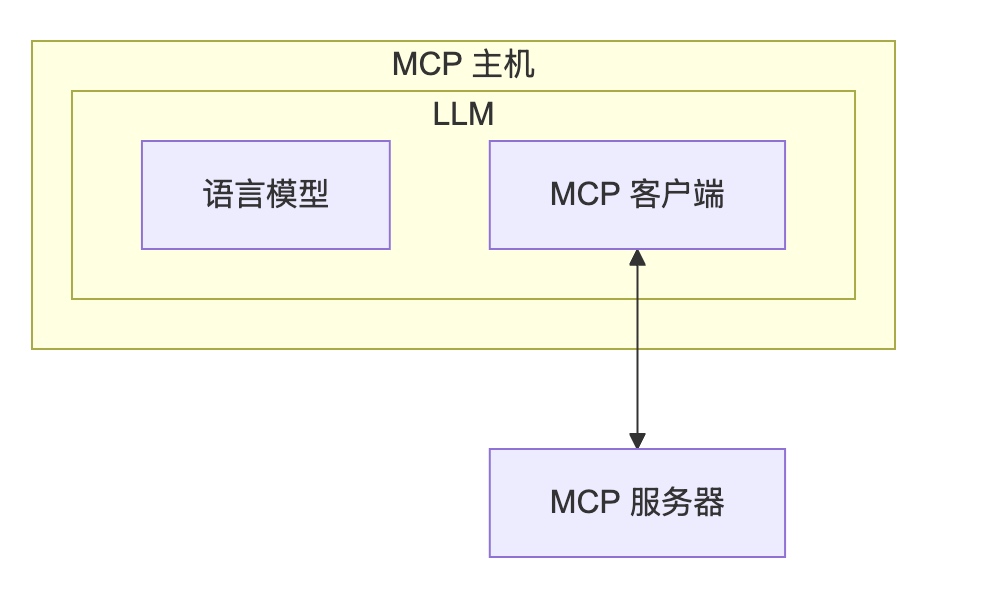

2. MCP 客户端 (The Bridge🌉)

这是连接 LLM 和 MCP 服务器的“桥梁”,通常嵌入在 LLM 应用内部。它的职责很简单:接收 LLM 发出的“求助”信号,准确地将请求转发给合适的 MCP 服务器,再把服务器处理完的结果带回给 LLM。

3. MCP 主机 (The Interface🖥️)

这就是我们直接交互的 AI 应用界面,比如 Claude Desktop、各种 AI 驱动的 IDE(像 Cursor),或其他集成了 MCP 功能的 AI 工具。它们不仅提供了与 LLM 对话的窗口,还内置了 MCP 客户端,使得 LLM 能够通过连接 MCP 服务器来“解锁”更多能力。

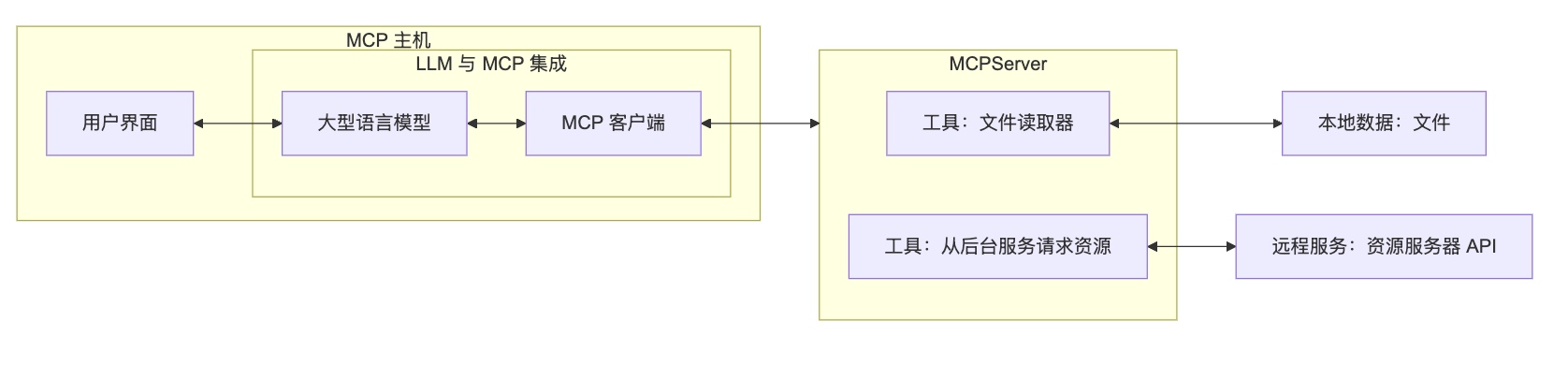

🤝 三者协作:MCP 工作流

这三个角色协同工作,就构成了一个完整的基于 MCP 的 AI 应用生态。

整个过程大致是这样的:

整个过程大致是这样的:

(用户发起请求 -> MCP 主机 -> LLM 分析 -> MCP 客户端 -> MCP 服务器执行 -> 返回结果 -> LLM 整合 -> MCP 主机呈现)

✨ MCP 为何是“游戏规则改变者”?

过去一年,我们见证了 AI 模型的飞速进化,从 GPT-4o 到 Claude 3.5 Sonnet,再到 Deepseek R1,推理能力越来越强,幻觉问题也改善明显。 然而,一个普遍的感受是:市面上的 AI 应用虽多,但大多是“另起炉灶”的新服务,很少能和我们已有的工作流程、常用的软件系统深度融合。换句话说,强大的 AI 模型与我们现有数字世界的“连接”,进展一直比较缓慢。

想象一下,你是否渴望有一个 AI 助手,能同时帮你联网搜索最新资讯、处理邮件、甚至一键发布你的博客文章?这些功能单个看似乎不难,但想把它们无缝集成到一个统一的 AI 体验中,却一直是巨大的挑战。

MCP 的出现,正是在试图打破这堵墙!

之前提到的那些 LLM 的“软肋”——充话费、订机票、调用特定 API、读取本地 Excel、分析 Figma 设计稿——通过 MCP 标准,正在逐步变为现实。不信?可以关注下 Cursor 或 Windsurf 等编辑器对 MCP 的支持,它们已经可以通过 MCP 插件实现诸如读取 Xcode 构建信息等酷炫操作了。 官方也提供了一些 MCP Server 的示例,展示了强大的集成能力(MCP 官方集成教学):

- Git 操作:读写、搜索 Git 仓库。

- GitHub 集成:管理 Repo、操作文件、调用 GitHub API。

- PostgreSQL 查询:安全地进行只读数据库访问。

- … 还有更多正在涌现!

🤔 MCP 的现状:机遇与挑战并存

正因为 MCP 有效地弥补了 LLM 的短板,它的价值正被越来越多人看到。社区也因此活跃起来,涌现了不少资源库和爱好者社群,方便大家查找和分享 MCP Server 实现:

- awesome-mcp-servers

- MCP Directory

- Cline - MCP Marketplace (甚至搞起了 MCP “应用市场”!) 但我们也要看到,MCP 目前仍处在发展初期,面临着一些现实的挑战:

安全 vs. 便捷:一个微妙的平衡

MCP 的一个核心设计理念是将服务器运行在本地,以此保护用户数据的隐私,避免敏感信息直接传给 LLM。这听起来很安全。但问题在于,本地运行的服务器可能拥有非常大的权限(比如访问整个文件系统),一旦服务器本身存在恶意代码或漏洞,风险不容小觑。

对于普通用户来说,判断一个 MCP 服务器是否安全几乎是不可能的任务。加上目前 MCP 在认证、权限控制方面的规范还比较初步,缺乏强制性的细粒度管理。

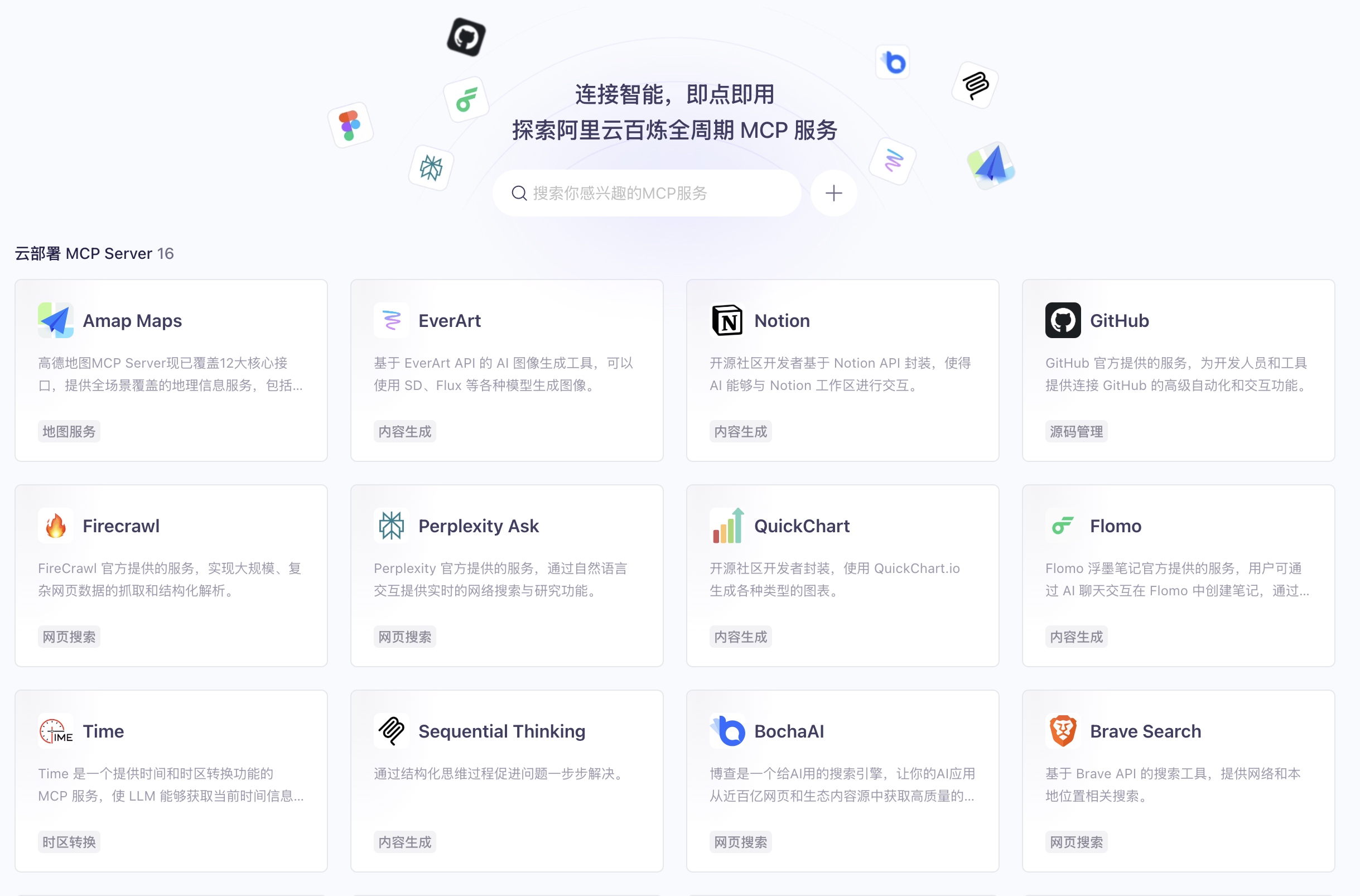

好消息是,像阿里云等云服务商已经开始提供百炼 MCP 服务,这在提升易用性的同时,也为未来在云端实现更安全的集成提供了可能。但如何在安全与便捷之间找到最佳平衡点,以及是否有足够的资源投入到类似“应用商店”的代码审核上,将是 MCP 生态持续需要面对和解决的问题。

🚀 未来展望:不止于“连接”

长久以来,我们习惯了通过结构化的数据格式(如 JSON)和预先定义好的 API 来让程序间协作。开发者们需要小心翼翼地维护接口契约,确保调用方和提供方“语言”一致。 现在,无论是 Function Calling 技术,还是 MCP 协议,都代表着一种进步:它们在传统 API 之上,加了一层“AI 友好”的接口(比如用自然语言描述需求)。这极大地简化了 API 的使用方式,让 LLM 替我们处理了生成结构化请求的繁琐工作。 但目前的 MCP 框架下,开发 MCP Server 依然需要工程师投入大量精力。一个大胆的畅想是:下一波变革会不会发生在 API 的“供给侧”? 我们是否永远需要这种“结构化调用”的方式?随着通用人工智能(AGI)的演进,如果未来出现了能直接理解并完成特定任务(比如直接操作数据库、直接调用系统功能)的专用 LLM,它们本身就具备了现在 MCP Server 的能力。那么,我们是否能实现模型之间的“直接对话”来完成任务,而不再需要编写固定的 Server 代码?未来充满想象!

🛠️ 如何上手体验 MCP?

心动不如行动!如果你想亲自体验 MCP 的魔力,可以试试以下工具(温馨提示:Claude 最近封号比较严格,新手可以优先考虑其他平台):

- Cursor: 一款集成了 AI 功能的代码编辑器,对 MCP 支持较好。

- CherryStudio: 另一个支持 MCP 的选择。 好消息是,你通常不需要自己从零开始开发 MCP Server。MCP 的核心优势就在于其通用性和标准化,这意味着社区会共享很多现成的轮子(当然,如果你想学习,重复造轮子也是个好方法)。

推荐资源:

- 官方 MCP Server 列表: https://github.com/modelcontextprotocol/servers (质量相对有保障)

- 社区 MCP Server 列表 (自行甄别): _ MCP.so _ Cursor Directory _ Pulsemcp _ Glama MCP Servers 需要注意的是,社区的 MCP Server 目前质量参差不齐,有些可能缺少文档或存在 Bug。建议从官方或文档齐全的 Server 开始尝试。具体的配置和实战步骤,我们后续会推出更详细的教程文章,敬请期待!

最后这是赛博程序员赵师傅给你提供的本期干货,后面会展开做一些案例讲解使用,预告一下~

读到这里,相信你对 MCP 已经有了更清晰的认识。如果觉得这篇文章对你有帮助,不妨点个「赞」和「在看」,或者分享给对 AI 技术感兴趣的朋友吧!也欢迎在评论区留下你的想法和疑问,一起交流探讨!