大模型手册: 保姆级用CherryStudio知识库

Cherry Studio 保姆级小白基础,带你学会大模型一站式使用,什么大模型配置、翻译、智能体、知识库、MCP 一网打尽!

Cherry Studio 是一个功能非常强大的 AI 本地助手,如果你厌倦了在各个平台之间跳转、频繁的切换各种模型和 API key ,那么这个 App 将会是你的懒人必备软件!

另外很多朋友在公司或者特殊环境使用存在数据隐私问题,需要尽量将使用数据存储在本地,那么这种本地型应用是你的本地助手!

大模型对话网站多如牛毛,而且使用几次就需要你订阅付费,一不小心就被坑笔钱,还要担心网站活不下去跑路的风险,那么对于个人使用是全部免费的应用是不是你的心动点!

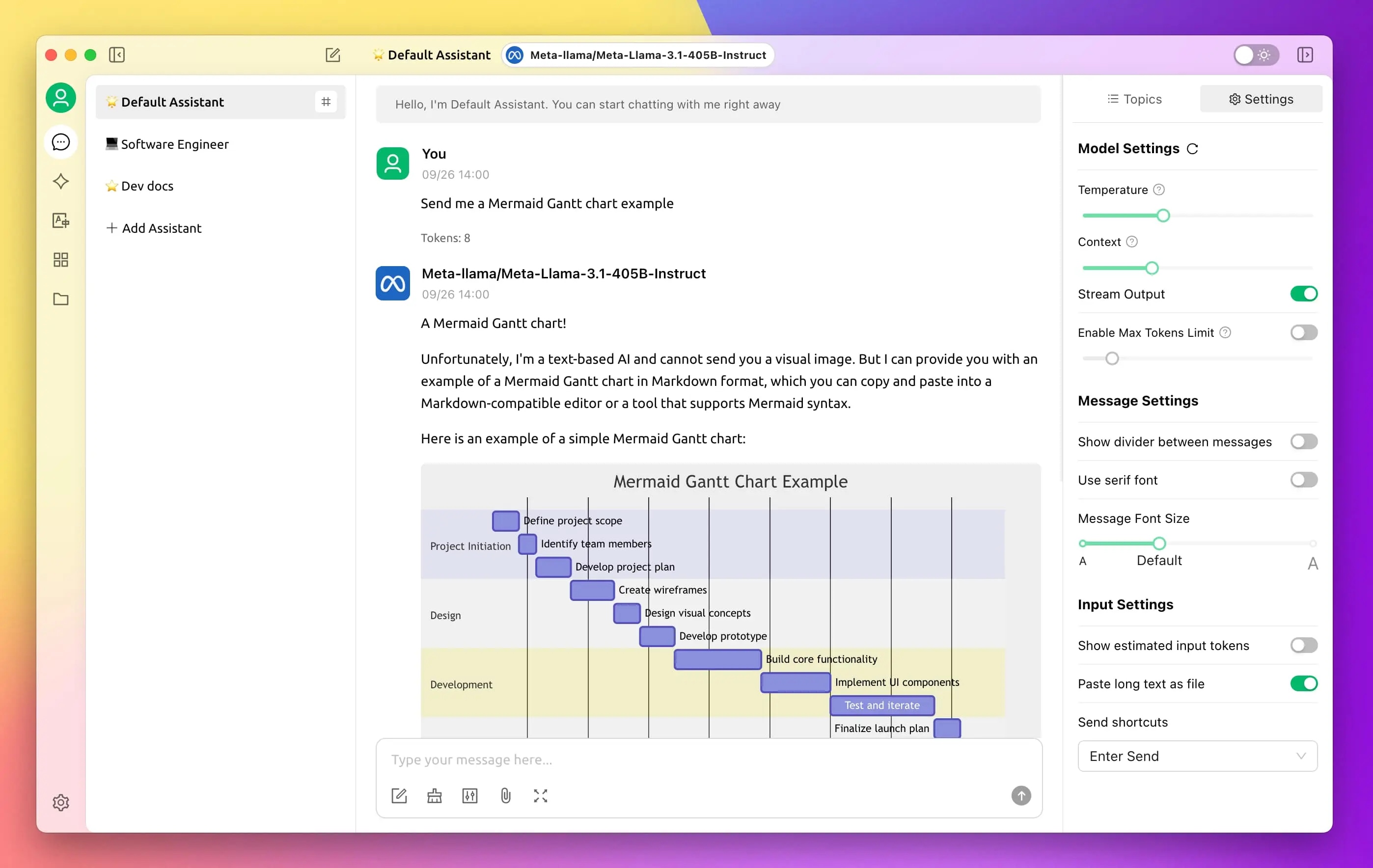

那么别犹豫了,开始看一眼界面你是否喜欢,不喜欢就别往下阅读了~

这个教程会教大家如何让大模型给我们写代码爬维基百科的文档供我们制作知识库,提取各种定律、原理供大家学习工作使用!(尽可能白嫖~)

0x00: 怎么下载使用

Windows 安装

注意:Windows 7系统不支持安装 Cherry Studio

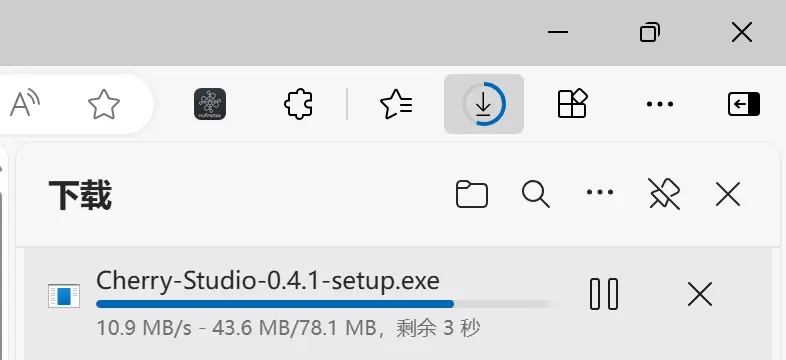

等待下载完成:

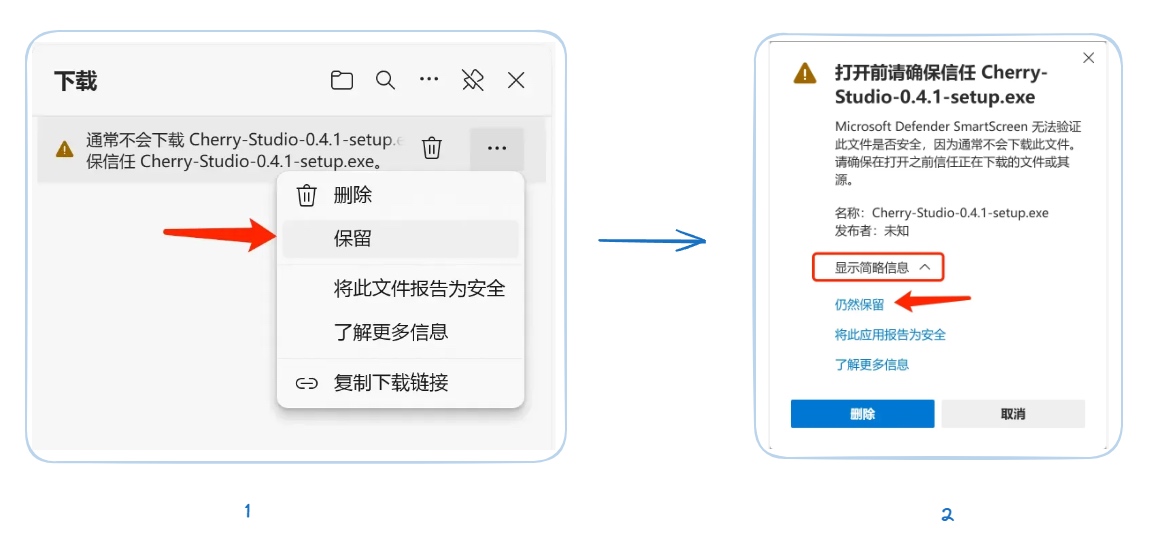

如果出现浏览器提示文件不被信任等情况选择保留即可 [选择保留] → [信任 Cherry-Studio]

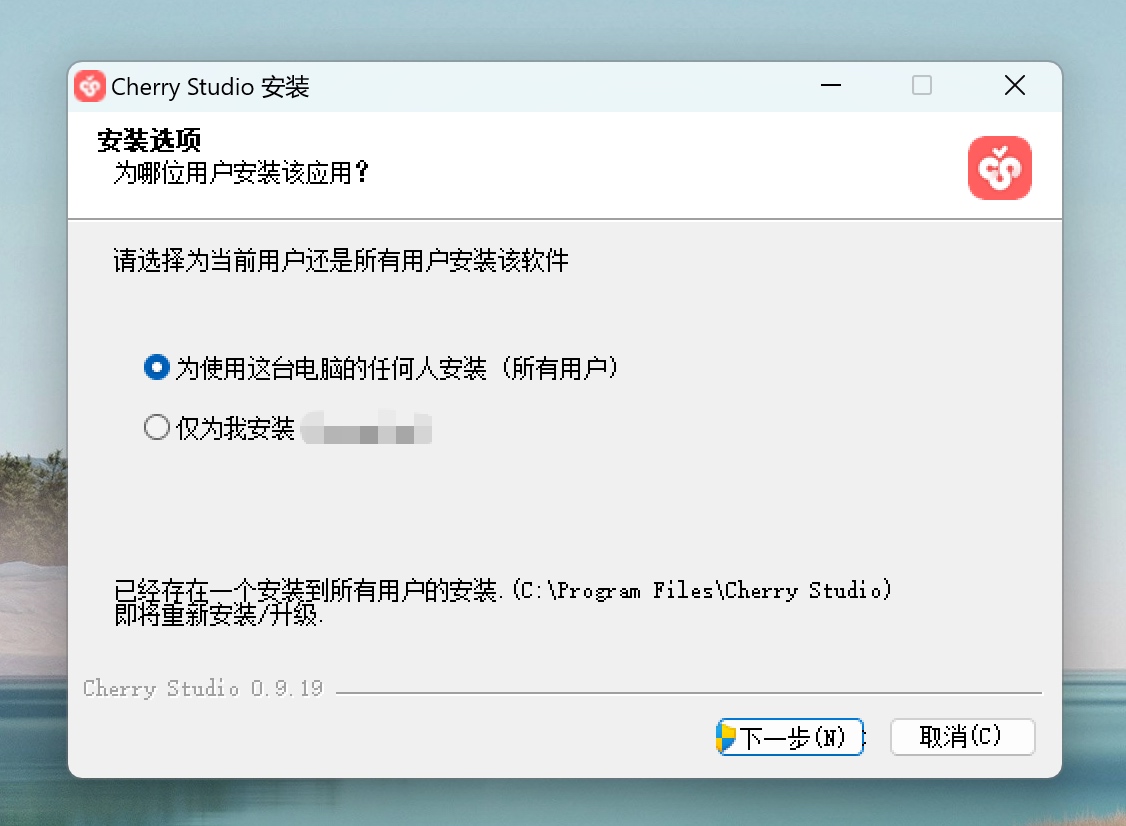

安装指引

windows 用户建议选一个 C 盘以外的盘进行安装,例如 D:\Programs\Cherry Studio

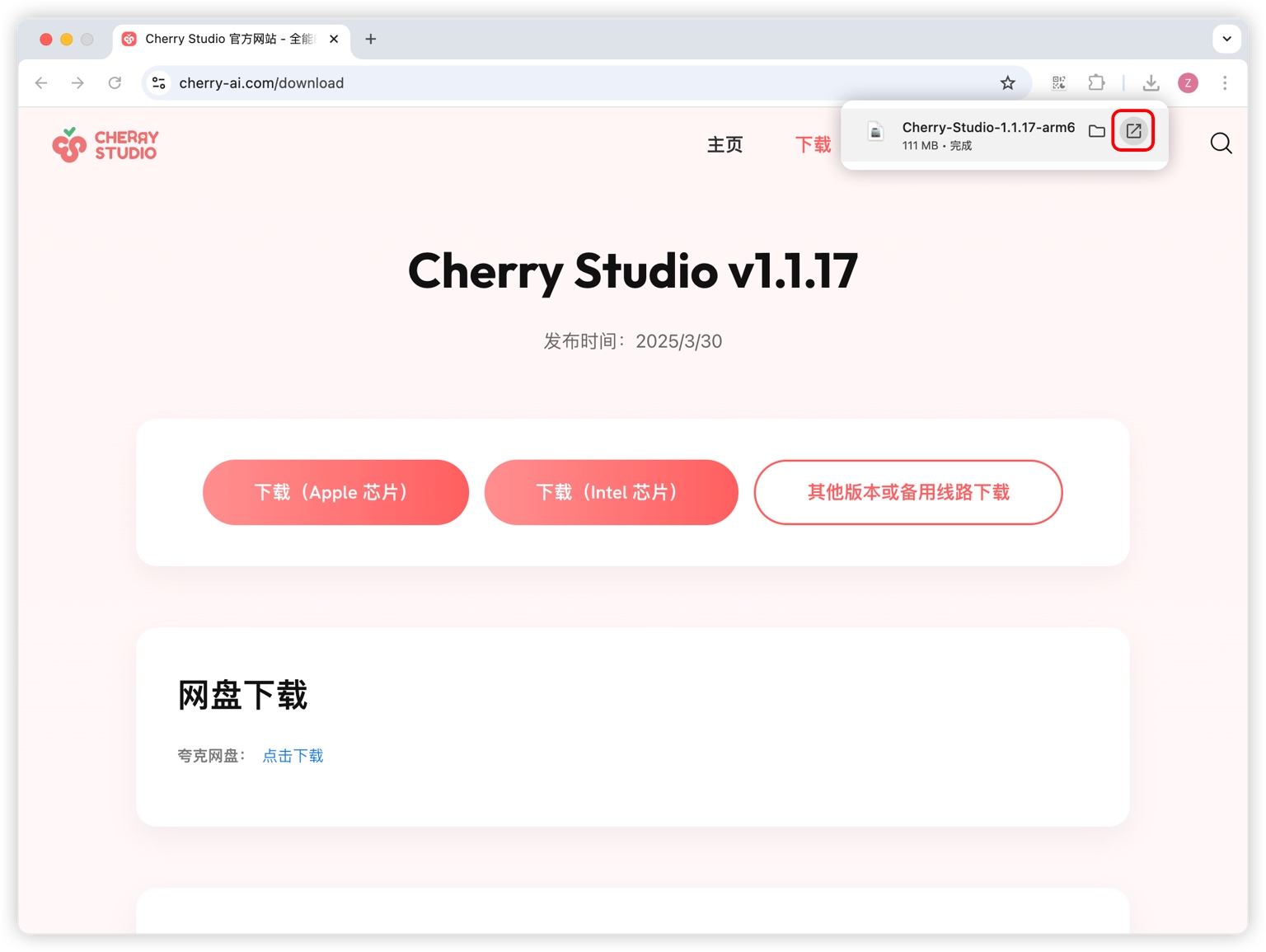

Mac 安装

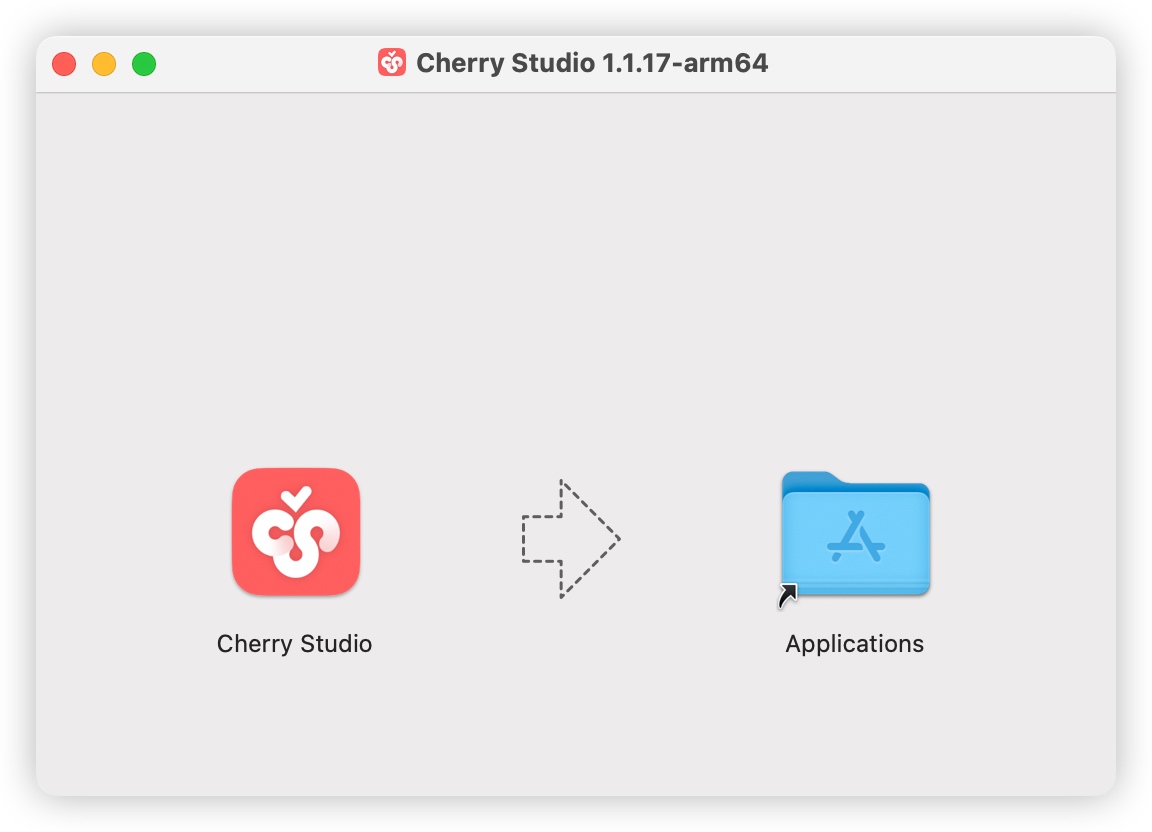

Mac 安装同理,下载后直接拖进 【应用程序/Applications】

请注意下载 自己 Mac 对应的芯片版本

M 系列放心安装 【Apple 芯片安装包】 老款 Intel 的安装 【Intel 版本安装包】

到启动台中寻找 Cherry Studio 图标并点击,能打开 Cherry Studio 主界面则安装成功。

App 图标:

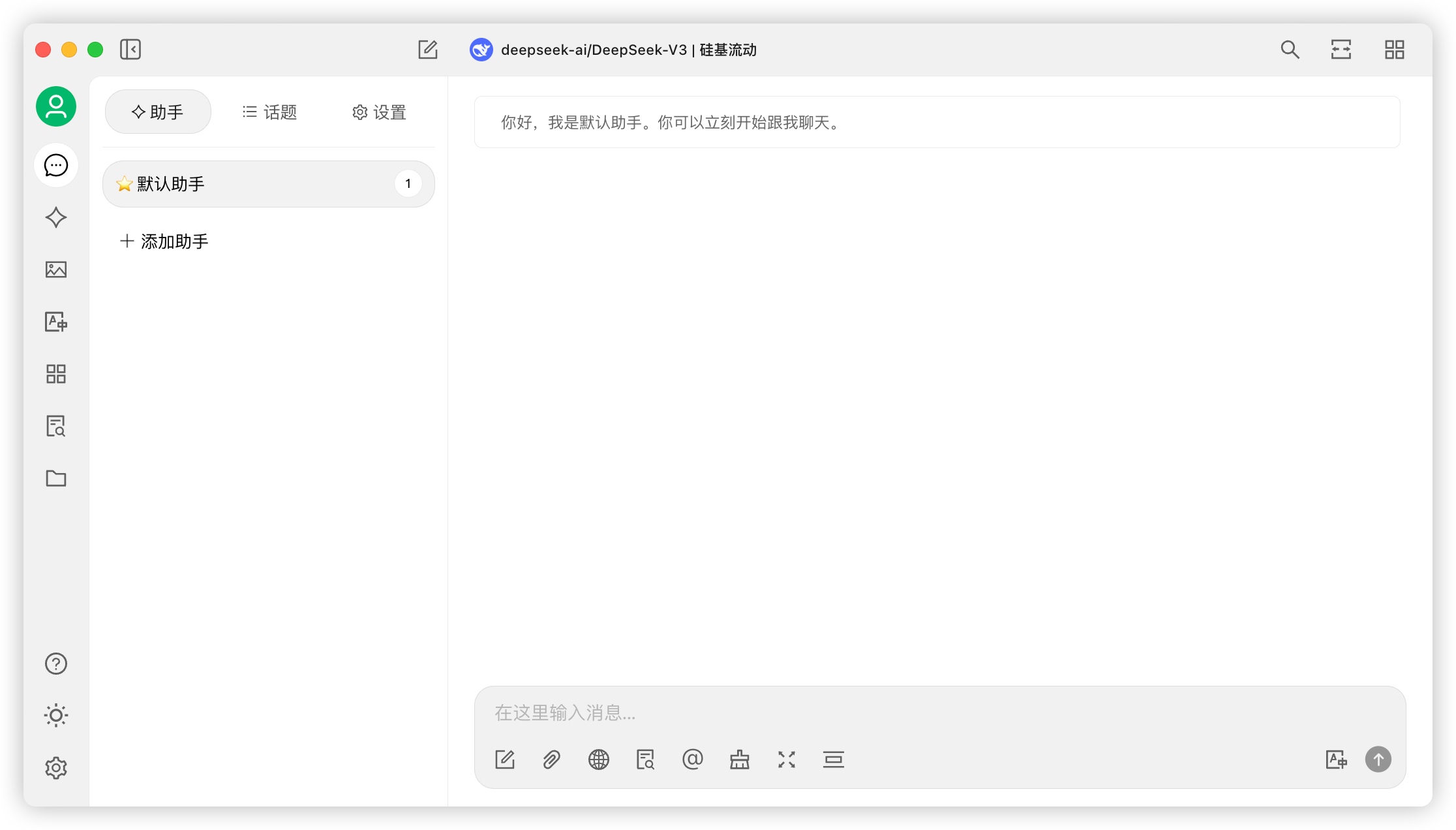

App 启动界面

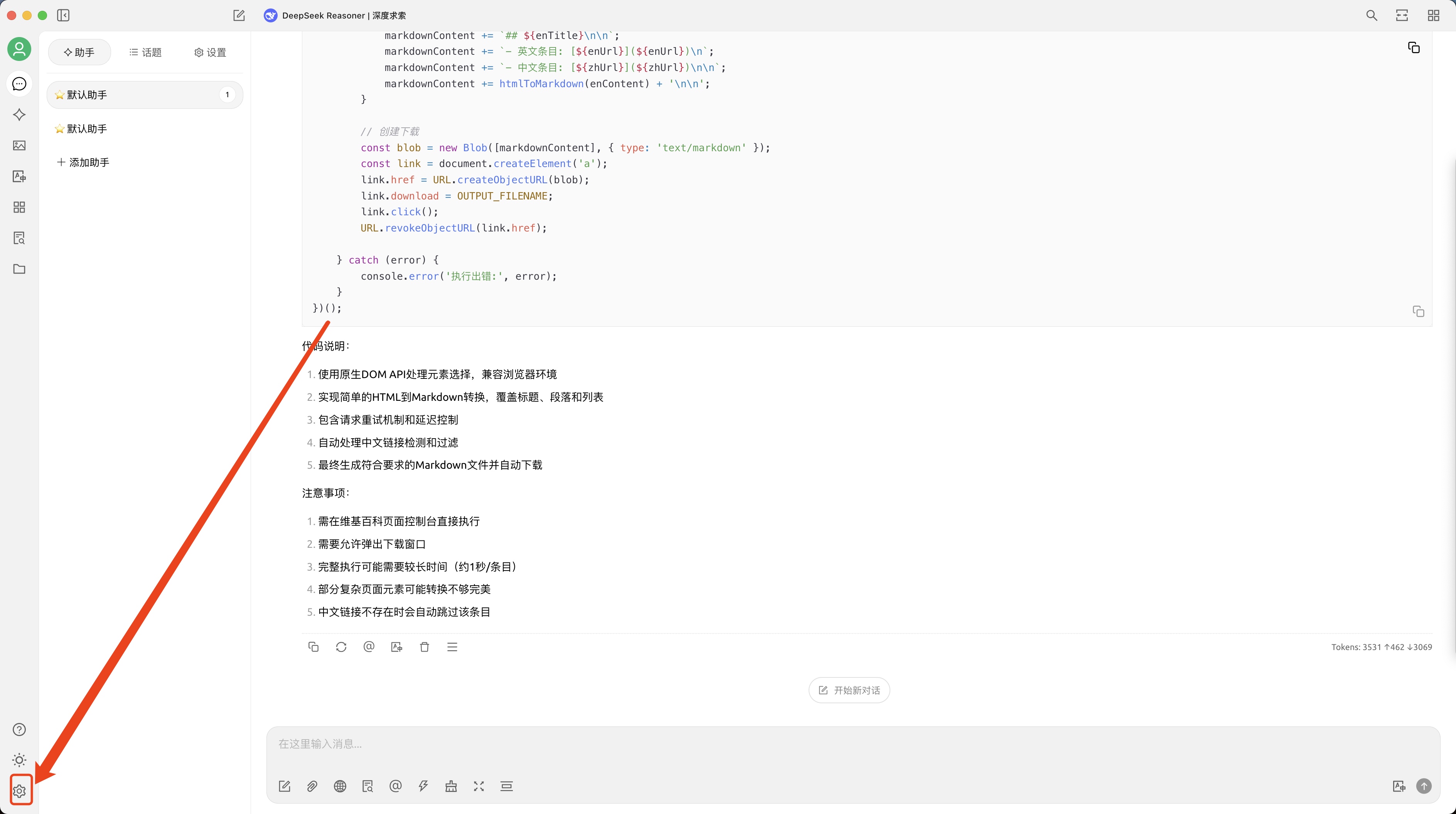

0x02 配置大模型和智能体

配置Chat大模型 - Deepseek

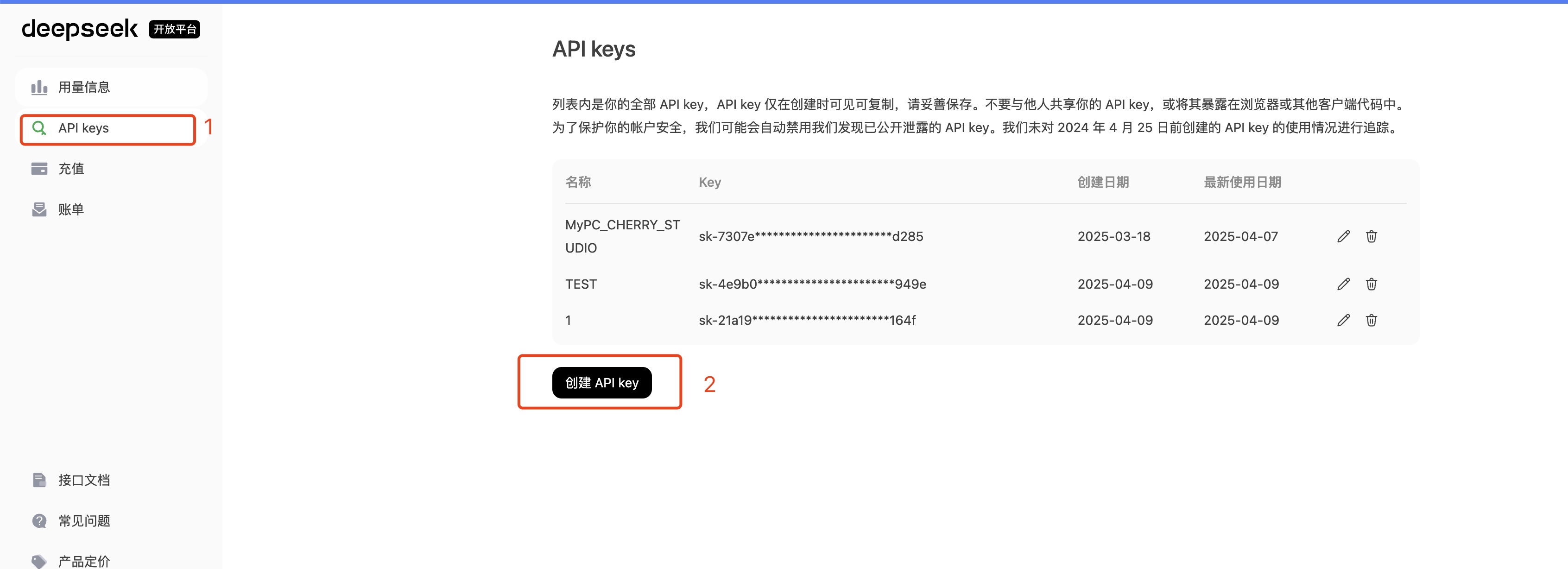

step1: 充值 10-100元,够用很久啦~

step2: 获取一个 API Key, 注意保存到一个安全地方

step3: 设置到 CherryStudio

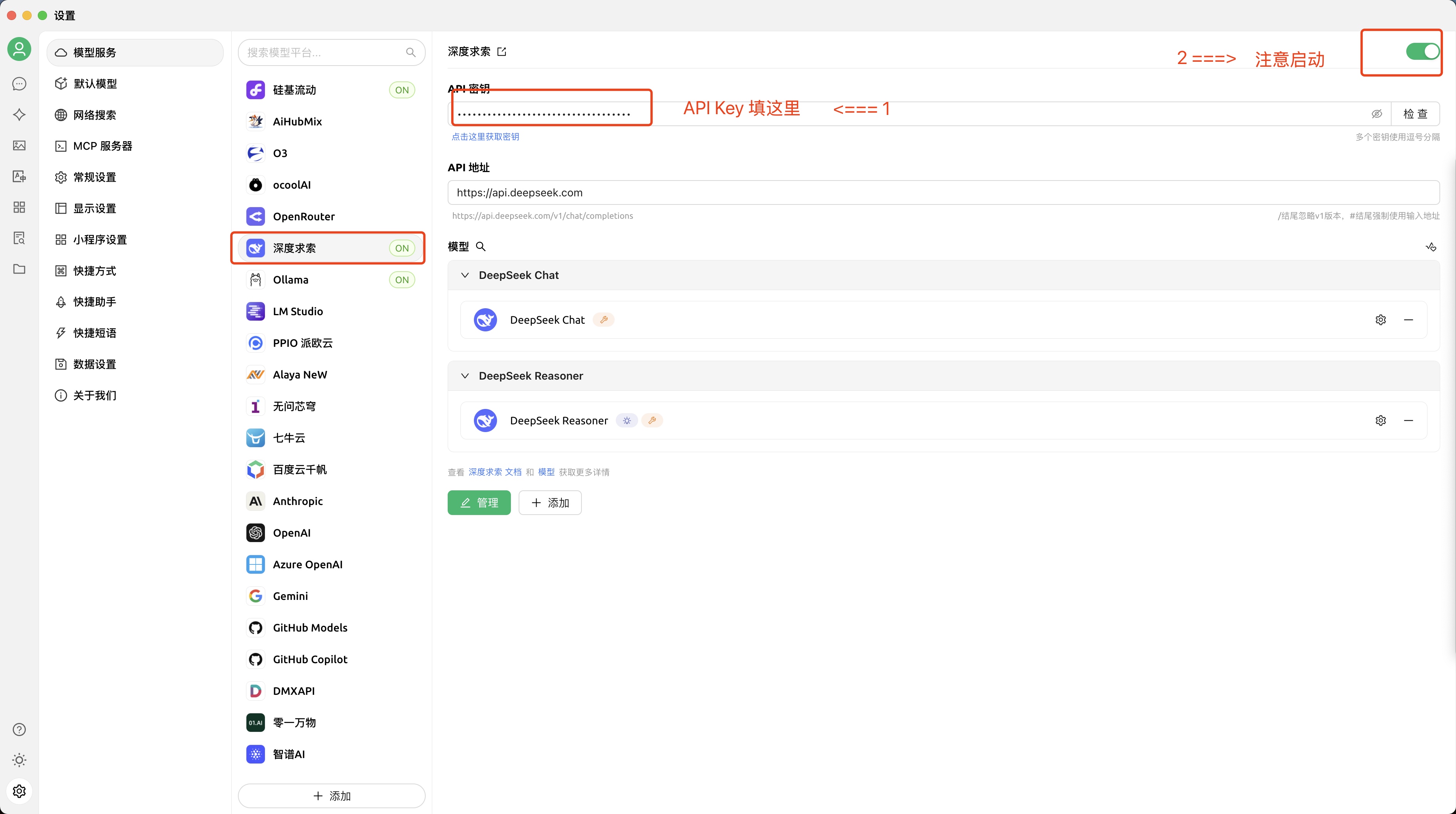

配置 Embedding 模型 - Ollama

打开 Ollama 官网 点击 Download 下载客户端!!!

Mac 非常简单,我就专门讲解一下 windows

Mac 非常简单,我就专门讲解一下 windows

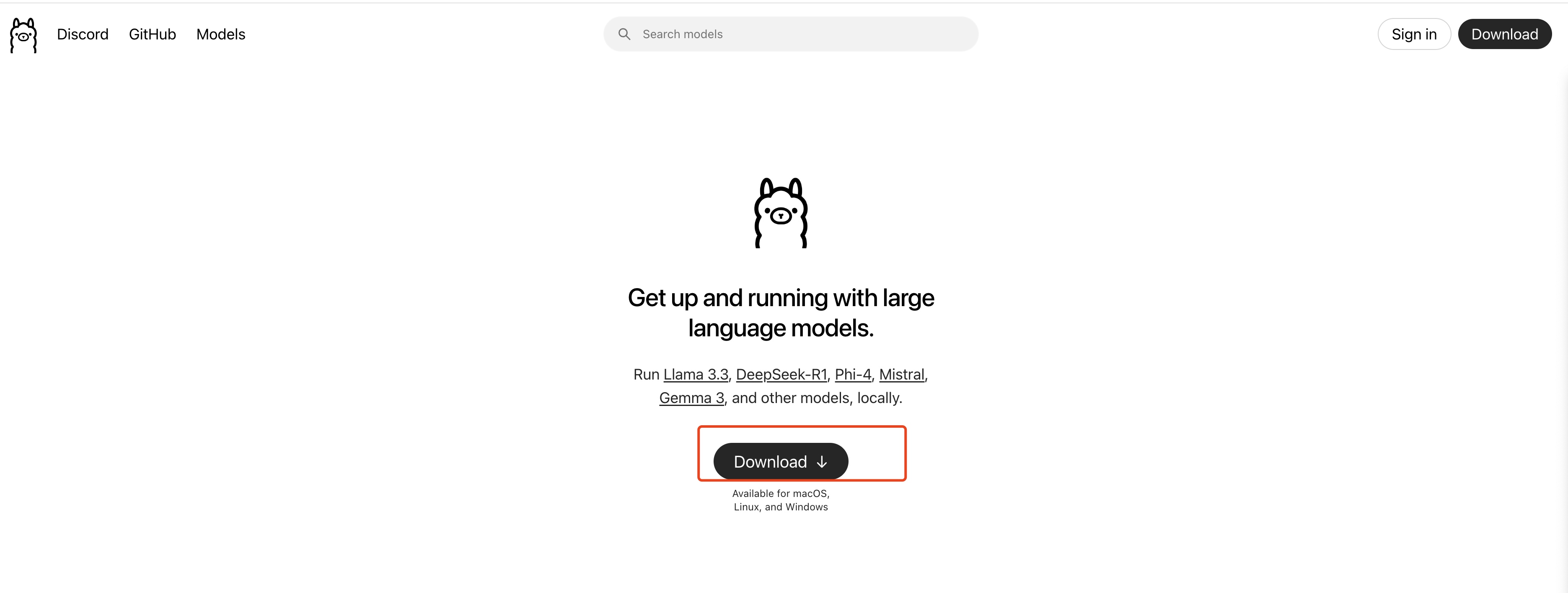

等待浏览器下载文件 OllamaSetup.exe,完成后双击该文件,出现如下弹窗,点击 Install 等待下载完成即可。

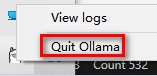

安装完成后,可以看到 Ollama 已经默认运行了。可以通过底部的导航栏找到 Ollama 标志,并右键后点击 Quit Ollama 退出Ollama或者查看 logs。

环境变量配置

Ollama可以像其他软件一样在电脑上完成一键安装,不同的是,建议按照实际需求配置下系统环境变量参数。以下是 Ollama 的环境变量配置说明。

| 参数 | 标识与配置 |

|---|---|

| OLLAMA_MODELS | 表示模型文件的存放目录,默认目录为当前用户目录即 C:\Users%username%.ollama\modelsWindows 系统 建议不要放在C盘,可放在其他盘(如 E:\ollama\models) |

| OLLAMA_HOST | 表示ollama 服务监听的网络地址,默认为127.0.0.1 如果想要允许其他电脑访问 Ollama(如局域网中的其他电脑),建议设置成 0.0.0.0 |

| OLLAMA_PORT | 表示ollama 服务监听的默认端口,默认为11434 如果端口有冲突,可以修改设置成其他端口(如8080等) |

| OLLAMA_ORIGINS | 表示HTTP 客户端的请求来源,使用半角逗号分隔列表 如果本地使用不受限制,可以设置成星号 * |

| OLLAMA_KEEP_ALIVE | 表示大模型加载到内存中后的存活时间,默认为5m即 5 分钟 (如纯数字300 代表 300 秒,0 代表处理请求响应后立即卸载模型,任何负数则表示一直存活) 建议设置成 24h ,即模型在内存中保持 24 小时,提高访问速度 |

| OLLAMA_NUM_PARALLEL | 表示请求处理的并发数量,默认为1 (即单并发串行处理请求) 建议按照实际需求进行调整 |

| OLLAMA_MAX_QUEUE | 表示请求队列长度,默认值为512 建议按照实际需求进行调整,超过队列长度的请求会被抛弃 |

| OLLAMA_DEBUG | 表示输出 Debug 日志,应用研发阶段可以设置成1 (即输出详细日志信息,便于排查问题) |

| OLLAMA_MAX_LOADED_MODELS | 表示最多同时加载到内存中模型的数量,默认为1 (即只能有 1 个模型在内存中) |

对于初学者,我们强烈建议你配置 OLLAMA_MODELS 来更改模型存储位置。 默认情况下,Ollama 模型会存储在 C 盘用户目录下的 .ollama/models 文件夹,占用 C 盘空间。 将其更改到其他分区可以更好地管理你的存储。

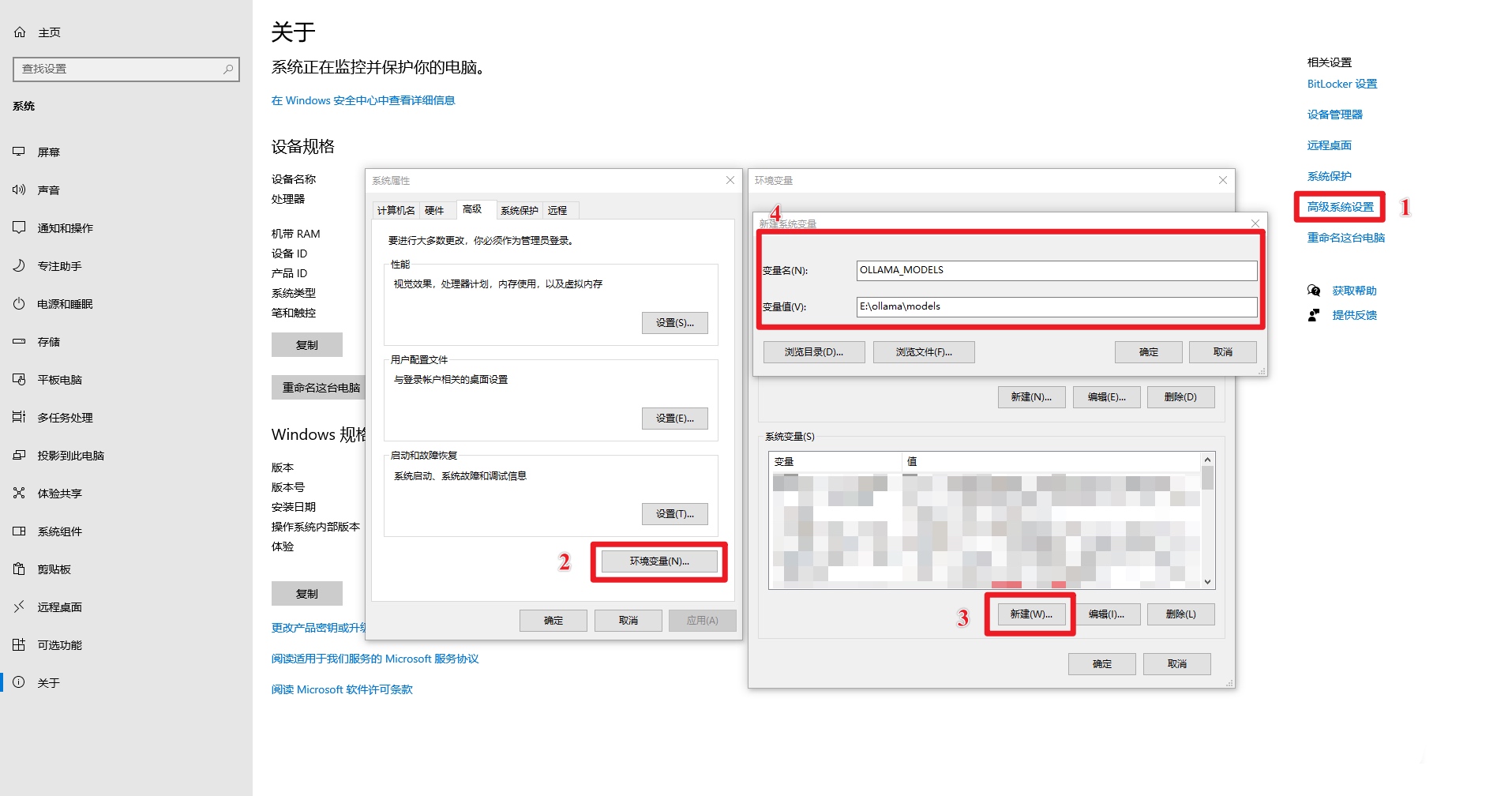

步骤 1:找到系统环境变量的设置入口。

方法 1:开始->设置->关于->高级系统设置->系统属性->环境变量。

方法 2:此电脑->右键->属性->高级系统设置->环境变量。

方法 3:开始->控制面板->系统和安全->系统->高级系统设置->系统属性->环境变量。

方法 4:Win+R 打开运行窗口,输入 sysdm.cpl,回车打开系统属性,选择高级选项卡,点击环境变量。

步骤 2:设置 OLLAMA_MODELS 环境变量 (更改模型存储位置)

- 在 “环境变量” 窗口的 “系统变量(S)” 区域 (或者 “用户变量(U)” 区域,根据你的需求选择),点击 “新建(W)…” 按钮。

- 在 “变量名(N)” 输入框中,输入:

OLLAMA_MODELS(注意大小写,建议全部大写)。 - 在 “变量值(V)” 输入框中,输入你想要设置的模型存储路径。 例如,如果你想将模型存储到 E 盘的

ollama\models文件夹下,你可以在 “变量值(V)” 中输入:E:\ollama\models(请根据你的实际情况修改盘符和文件夹路径)。- 注意: 请确保你输入的路径是 已经存在的文件夹 或者 你希望创建的文件夹的父目录存在。 Ollama 在首次运行时可能会自动创建

models文件夹,但最好提前创建好ollama文件夹,确保路径的正确性。 - 示例: 为了将模型存储到 E 盘的

ollama\models文件夹,你可以在 “变量值(V)” 中输入:E:\ollama\models

- 注意: 请确保你输入的路径是 已经存在的文件夹 或者 你希望创建的文件夹的父目录存在。 Ollama 在首次运行时可能会自动创建

- 点击 “确定” 按钮,关闭 “新建系统变量” (或者 “新建用户变量”) 窗口。

注意: 如果你不知道如何设置

OLLAMA_MODELS环境变量,可以参考下面的示例。

步骤 3:重启 Ollama 或 PowerShell 使环境变量生效

环境变量设置完成后,你需要 重启 Ollama 服务 或者 重新启动你的 命令提示符 (CMD) 或 PowerShell 窗口,才能让新的环境变量生效。

重启 Ollama 服务: 如果你运行了 ollama serve,先 Ctrl + C 停止,再重新运行 ollama serve。

重启命令提示符/PowerShell: 关闭所有已打开的窗口,重新打开新的窗口。

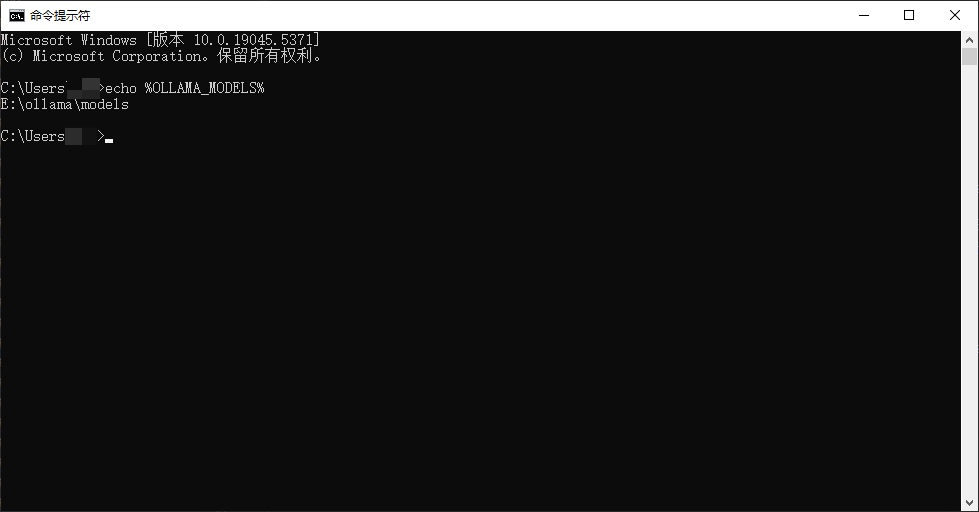

步骤 4:验证环境变量是否生效

重新打开 命令提示符 (CMD) 或者 PowerShell。

验证 OLLAMA_MODELS: 输入以下命令并回车:

echo %OLLAMA_MODELS%输出:E:\ollama\models (如果你设置的是 E:\ollama\models)

运行Ollama

- 建议配置机器启动时候,自动启动 Ollama 即可

- 命令行语句启动

ollama serve

验证安装ok

终端输入:ollama -h

看到输出有帮助提示,就是成功,类似:

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information获取 Embedding 模型(bge-m3)

终端使用Ollama :

ollama pull bge-m3看到类似输出,就是成功啦,时间取决你的网速~

pulling manifest

pulling daec91ffb5dd... 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 1.2 GB

pulling a406579cd136... 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 1.1 KB

pulling 0c4c9c2a325f... 100% ▕████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████▏ 337 B

verifying sha256 digest

writing manifest

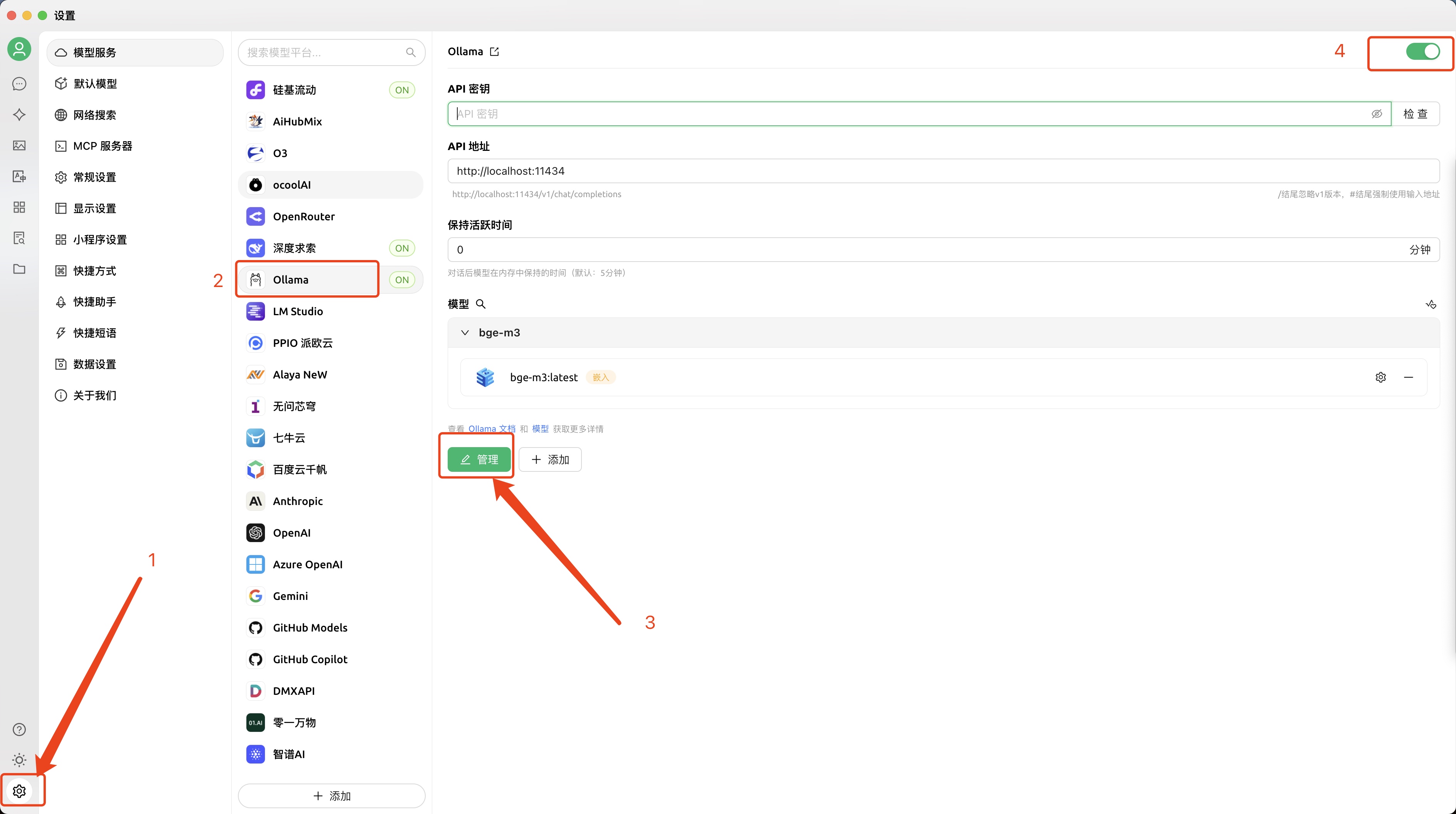

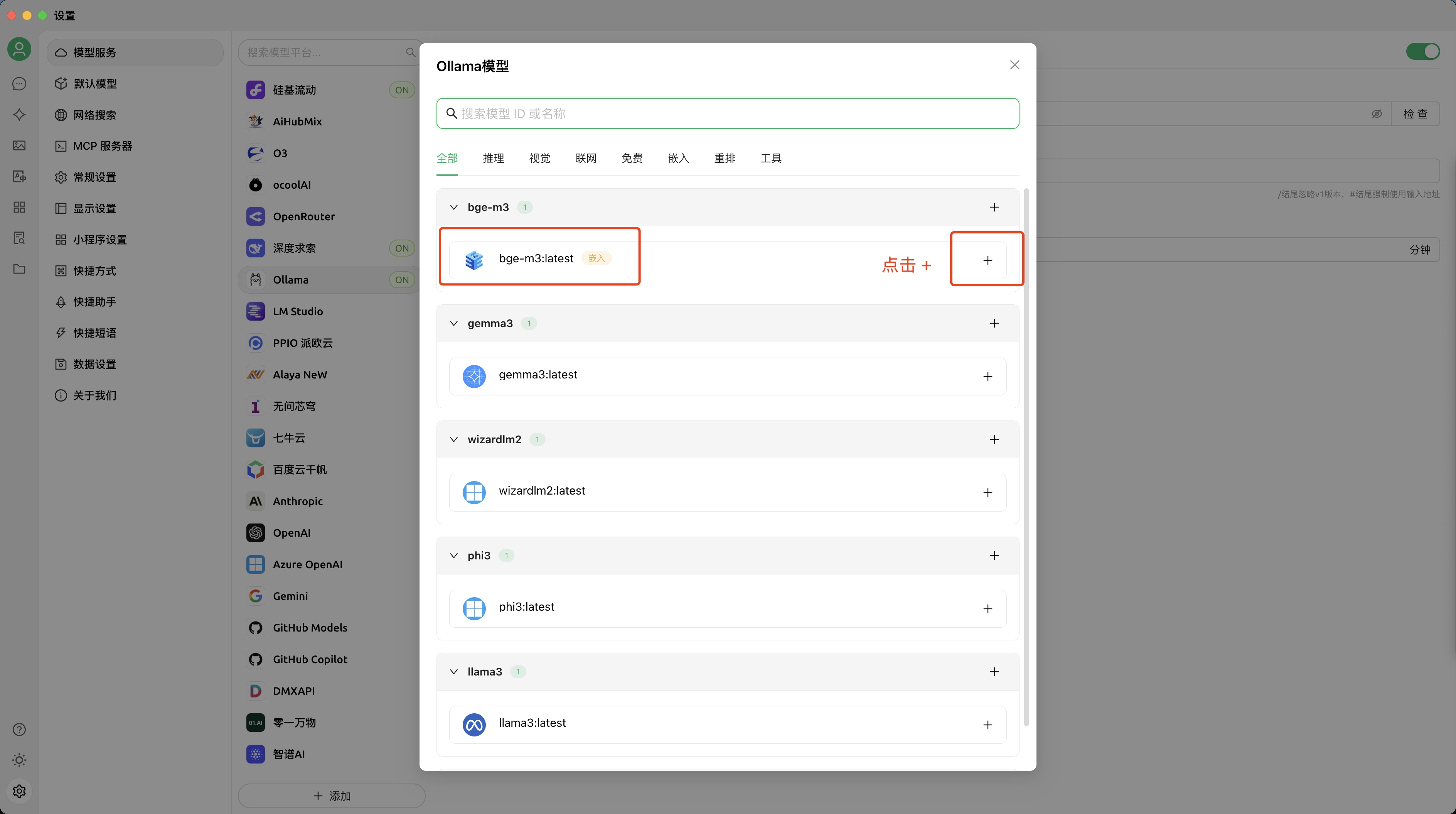

success回 CherryStudio 设置开启

打开设置页,找到 Ollama 点开

在管理页,勾选 bge-m3 即可

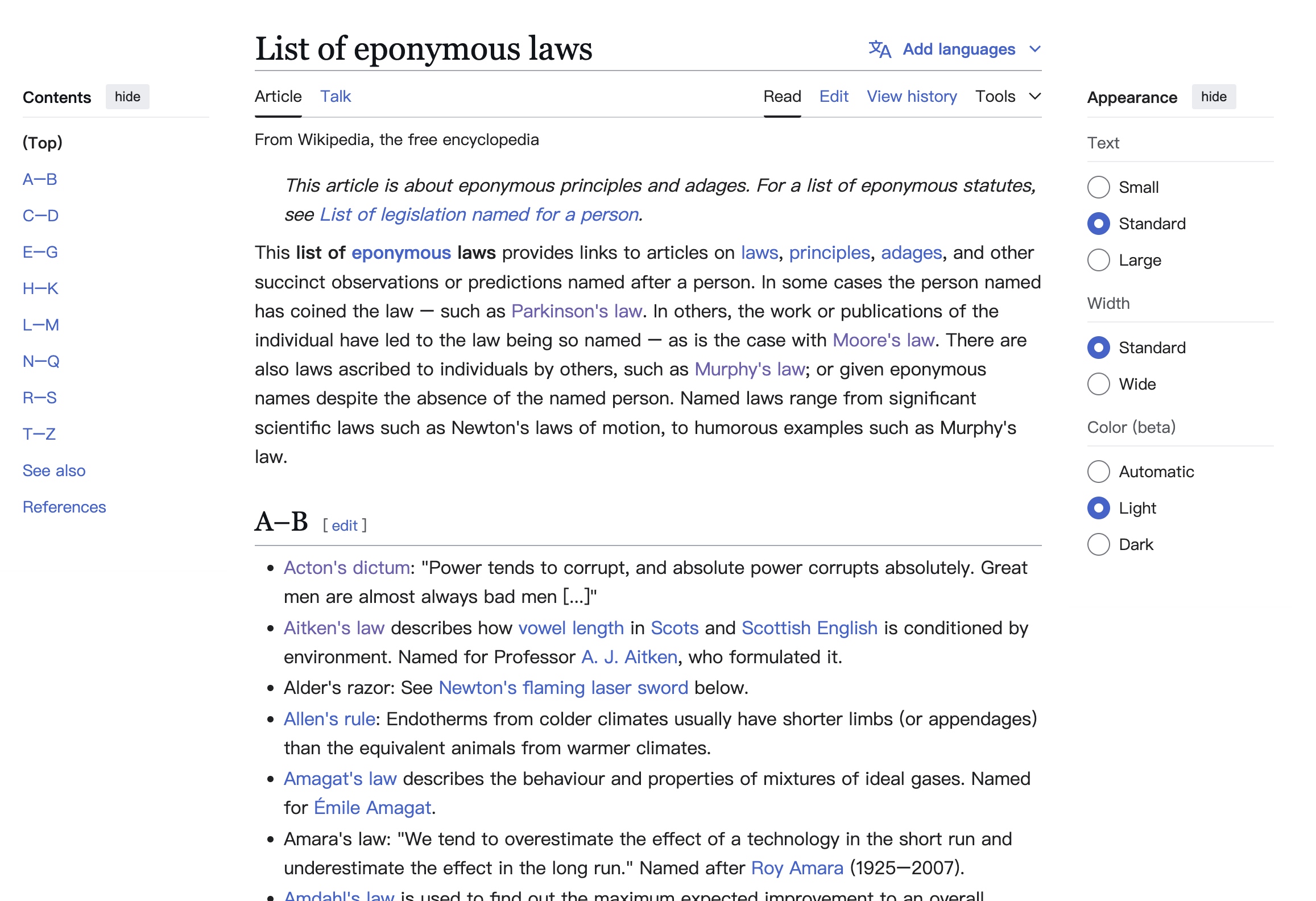

0x03 怎么获取一个 wiki 文档作为知识库?

wiki 上有一个页面汇总了各种定律,我们想都爬了放到一个文档!后面用起来不是很爽~

爬虫是会违法的,注意这里仅供学习!

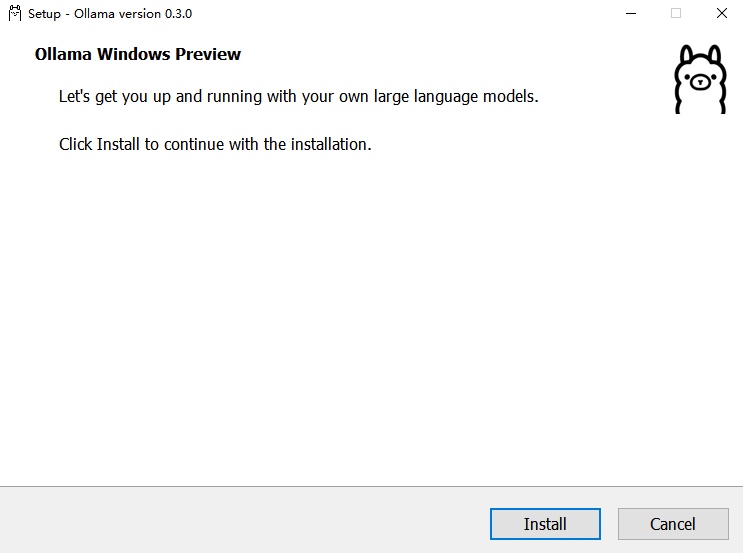

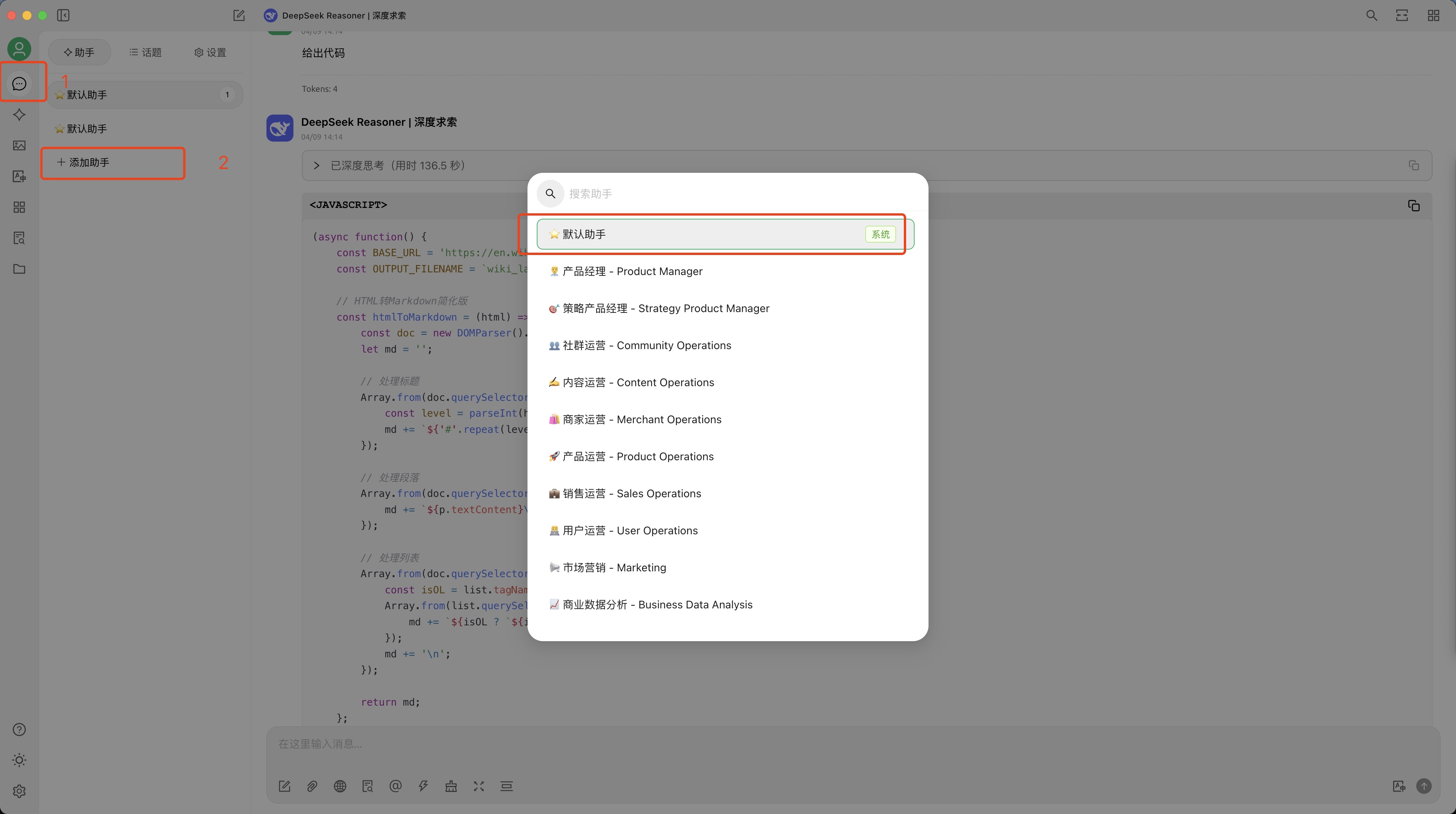

让大模型写代码获取文档

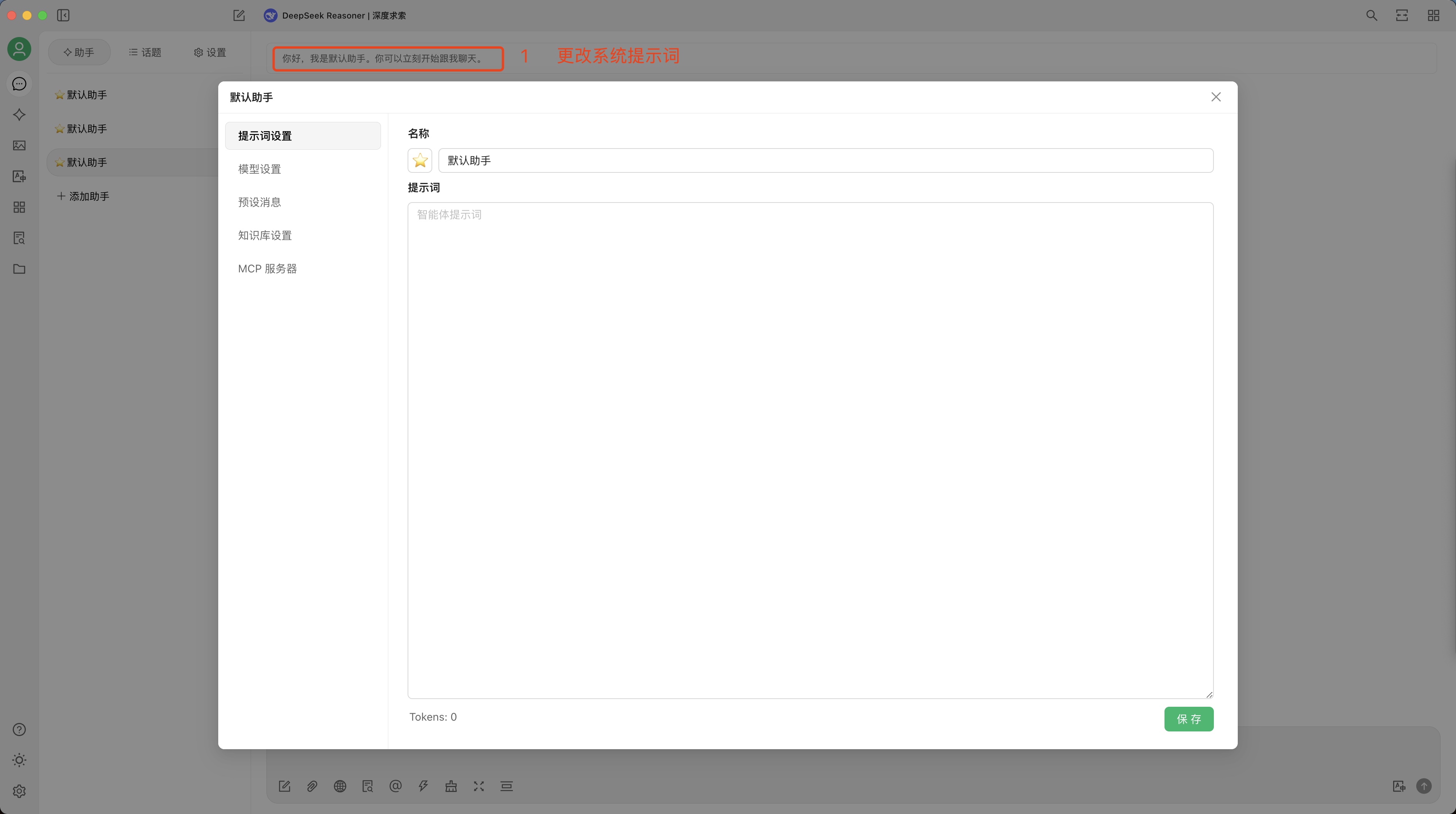

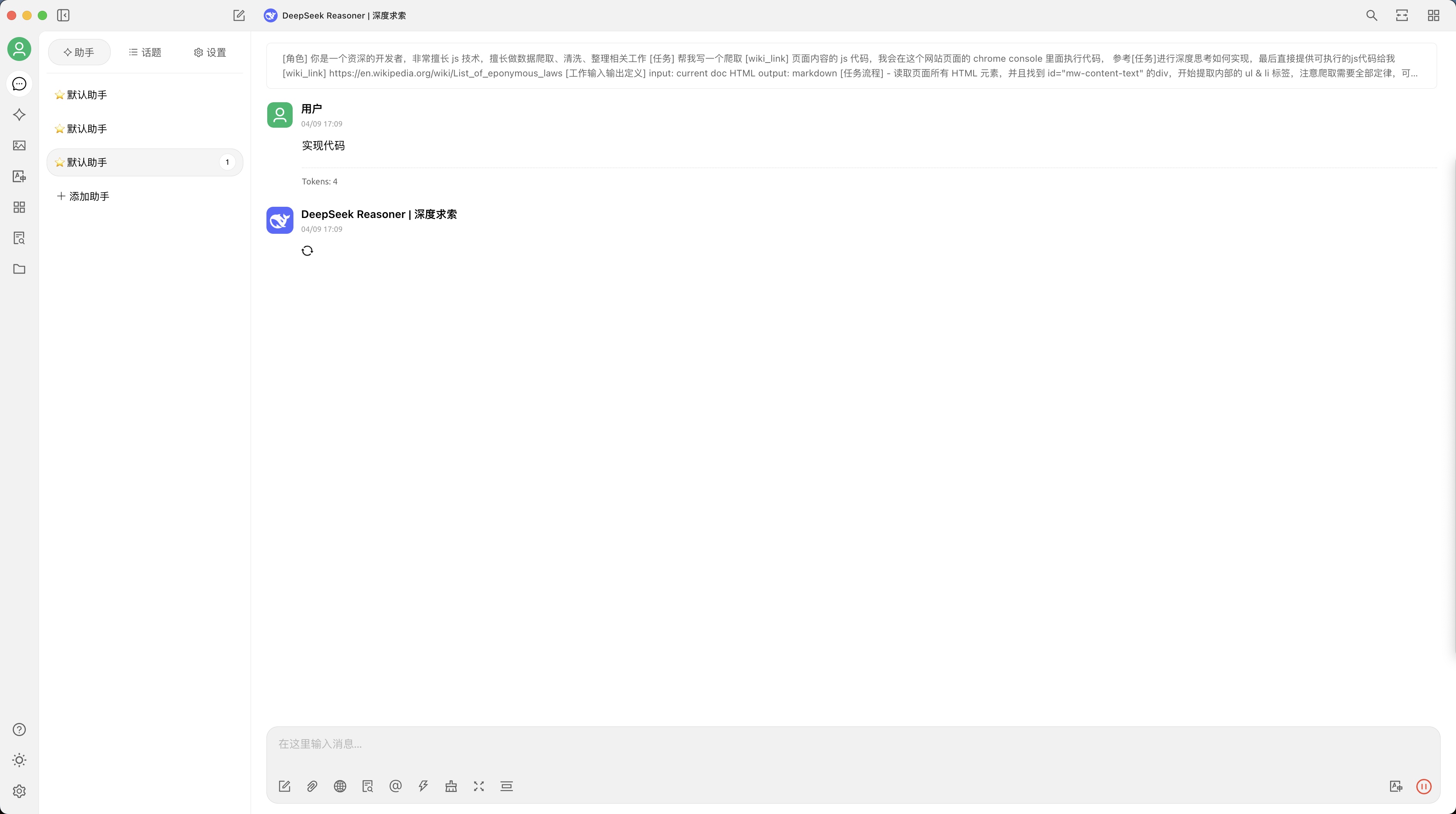

step1 打开一个对话,选择好 deepseek 的推理模型

输入以下提示词:

[角色]

你是一个资深的开发者,非常擅长 js 技术,擅长做数据爬取、清洗、整理相关工作

[任务]

帮我写一个爬取 [wiki_link] 页面内容的 js 代码,我会在这个网站页面的 chrome console 里面执行代码,

参考[任务]进行深度思考如何实现,最后直接提供可执行的js代码给我

[wiki_link]

https://en.wikipedia.org/wiki/List_of_eponymous_laws

[工作输入输出定义]

input: current doc HTML

output: markdown

[任务流程]

- 读取页面所有 HTML 元素,并且找到 id="mw-content-text" 的div,开始提取内部的 ul & li 标签,注意爬取需要全部定律,可以慢一点比如 delay 200ms,如果页面出现报错,重试2-3次

- 定义输出文档条目格式: 多个2级标题 + 内容

- 1级标题: wiki 定律大全

- 2级标题: 英文定律页面的标题(每个定律一个2级标题+内容)

- 内容:

- 1. 包含两个链接,中/英文wiki条目的链接

- 2. 定律页面正文,看看可以识别英文HTML的各个标题和内容作为合适的 markdown 标题和内容一并合并到条目,注意尽可能提取全部英文页面信息

- 识别 li 标签内部元素,提取 a 标签的 link 网页,识别英文页面链接和提取英文页面内容,忽略跨域保护我们在同一个页面执行代码。

- 识别英文页面内容对应的中文页面链接,从 id = p-lang-btn-label 的 div 中识别 ul 标签内的 class = interwiki-zh 的 li 标签,提取 li 标签的 a 标签对应链接为中文链接

- 如果没有,跳过这个定律提取

- 提取到中文链接后,合并英文标题和英文内容正文,按照汇总后续统一输出到 markdown,

- 最后输出相关内容填充到一个 markdown 文件,命名为 wiki_laws_{timestamp}.md然后发起对话就行~ “实现代码”

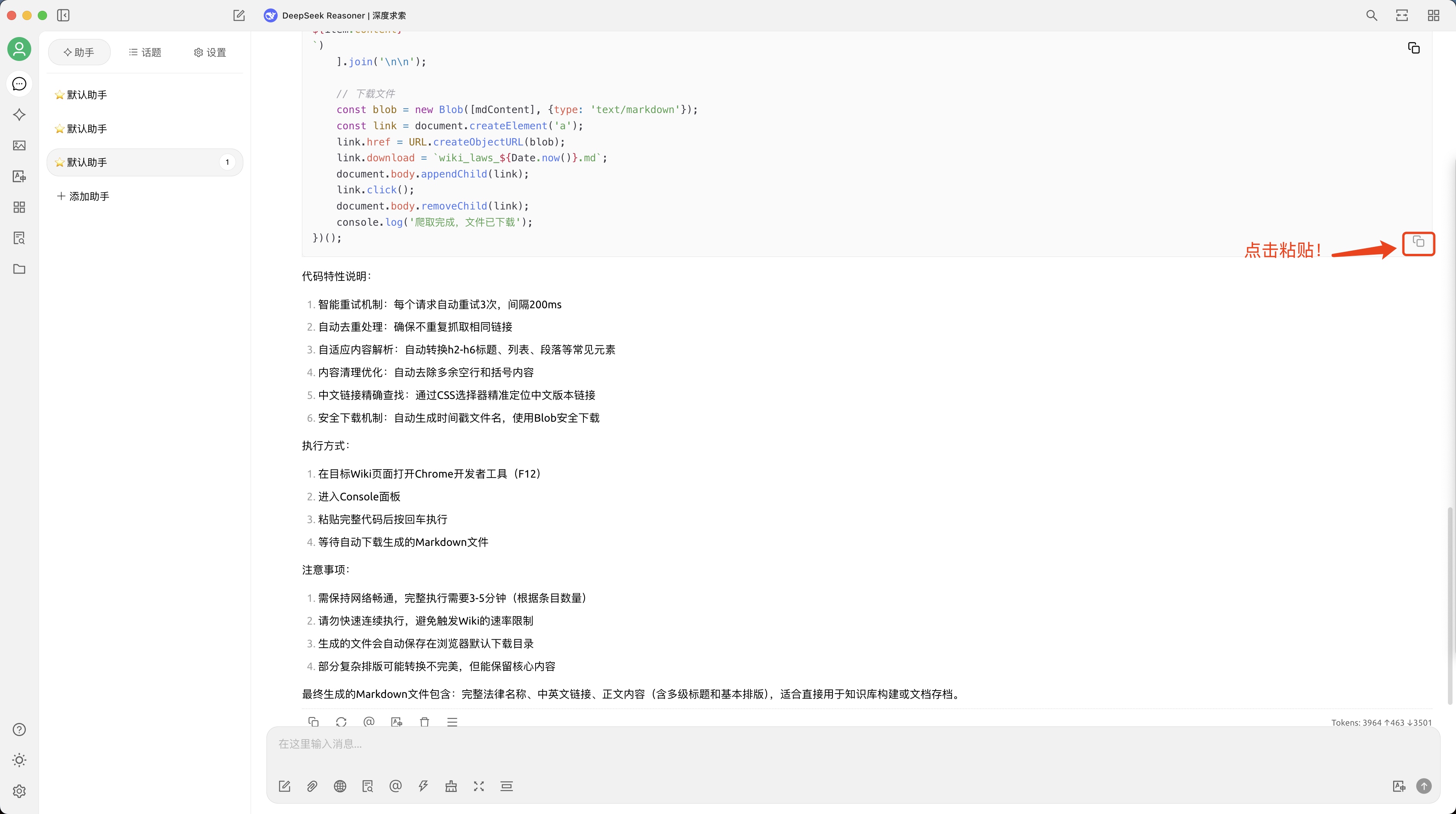

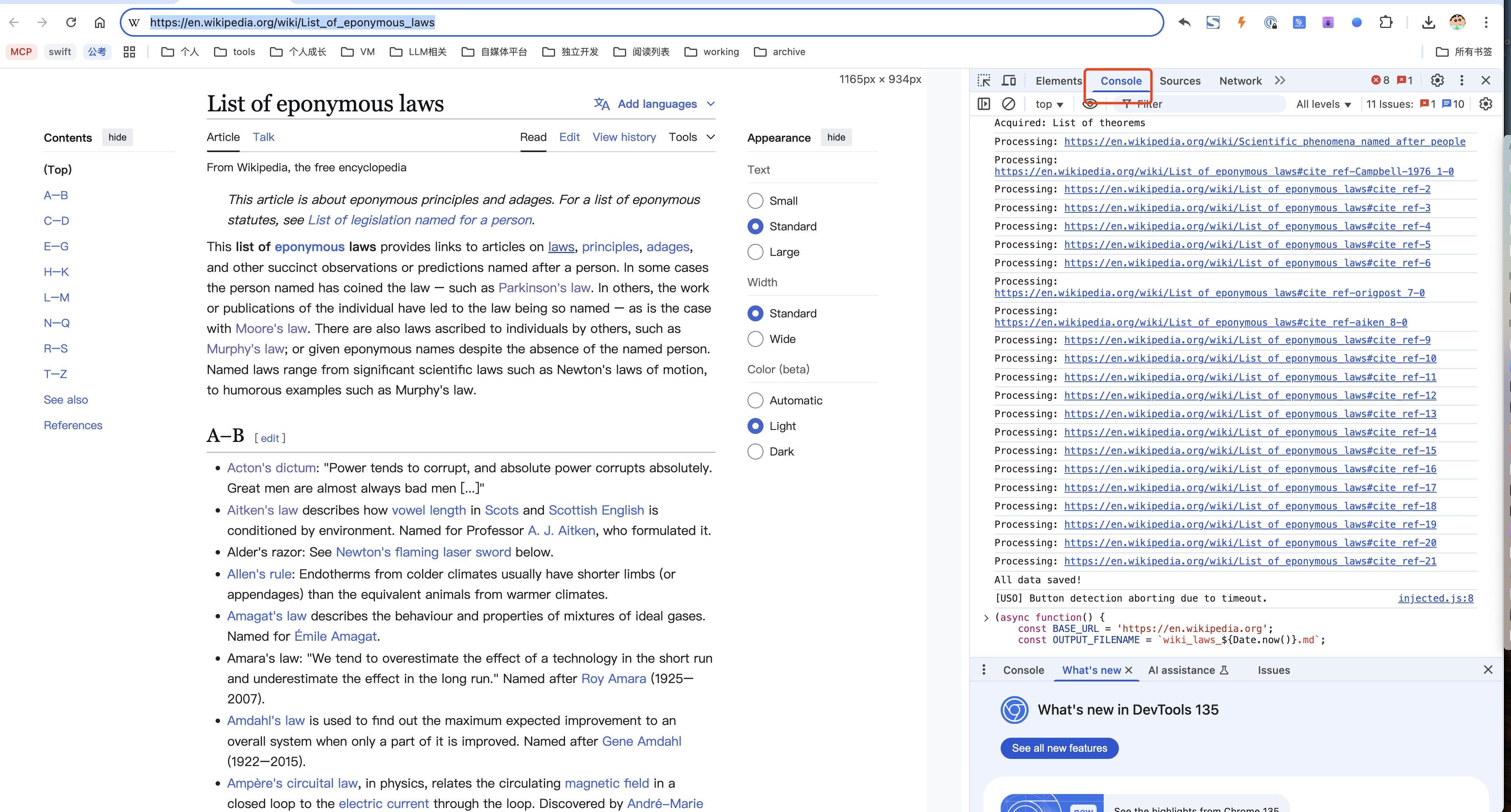

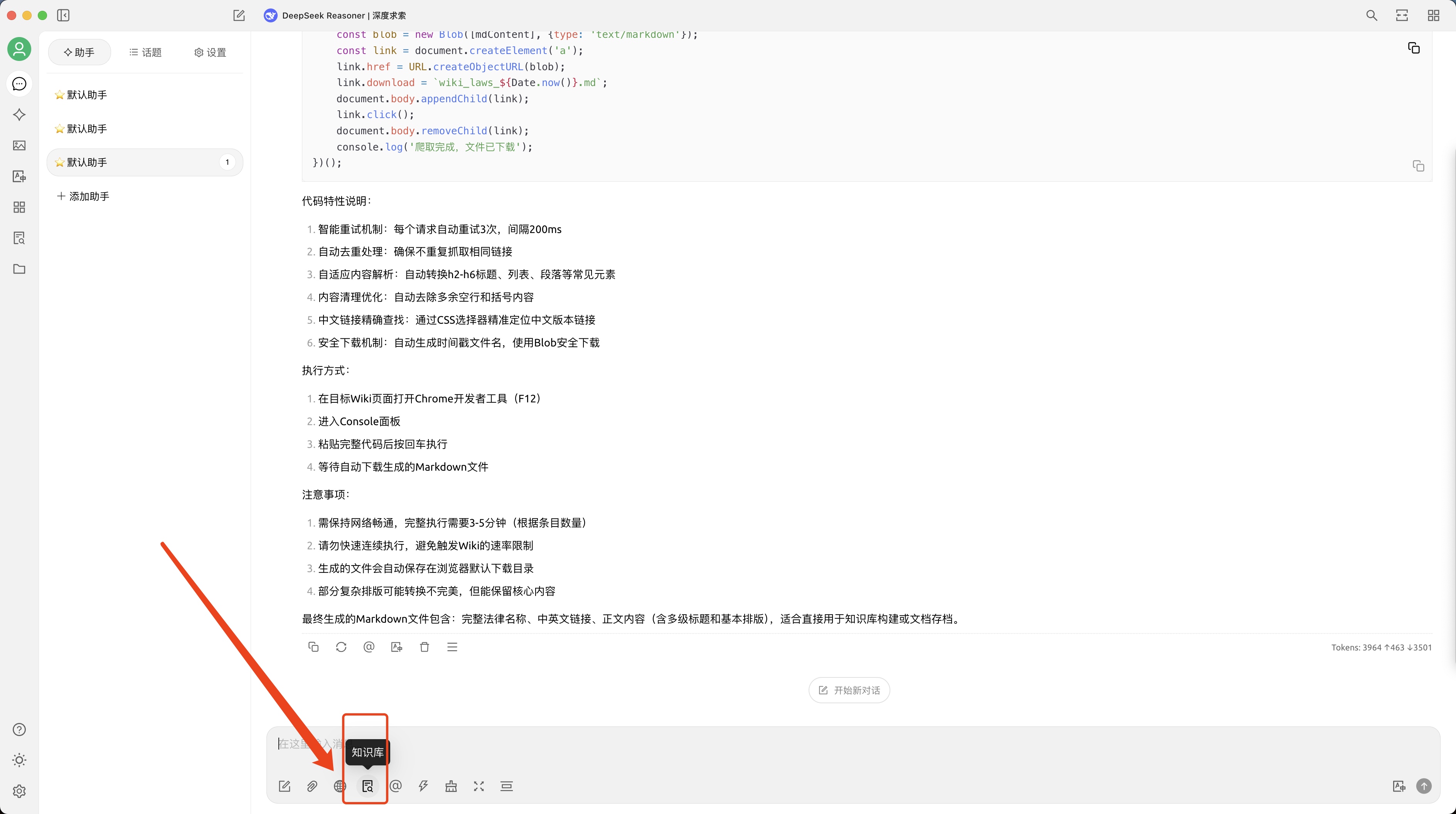

粘贴生成好的代码到浏览器

先把 deepseek 生成代码粘贴好~

在 wiki 页面 laws

2种方法打开 Console/控制台, 把代码贴进去输入就好,等一会执行看看,有报错问 deepseek!

- 在目标Wiki页面打开Chrome开发者工具(F12)-> 切换到 Console/控制台

- 在目标Wiki页面右键 -> 检查 -> 切换到 Console/控制台

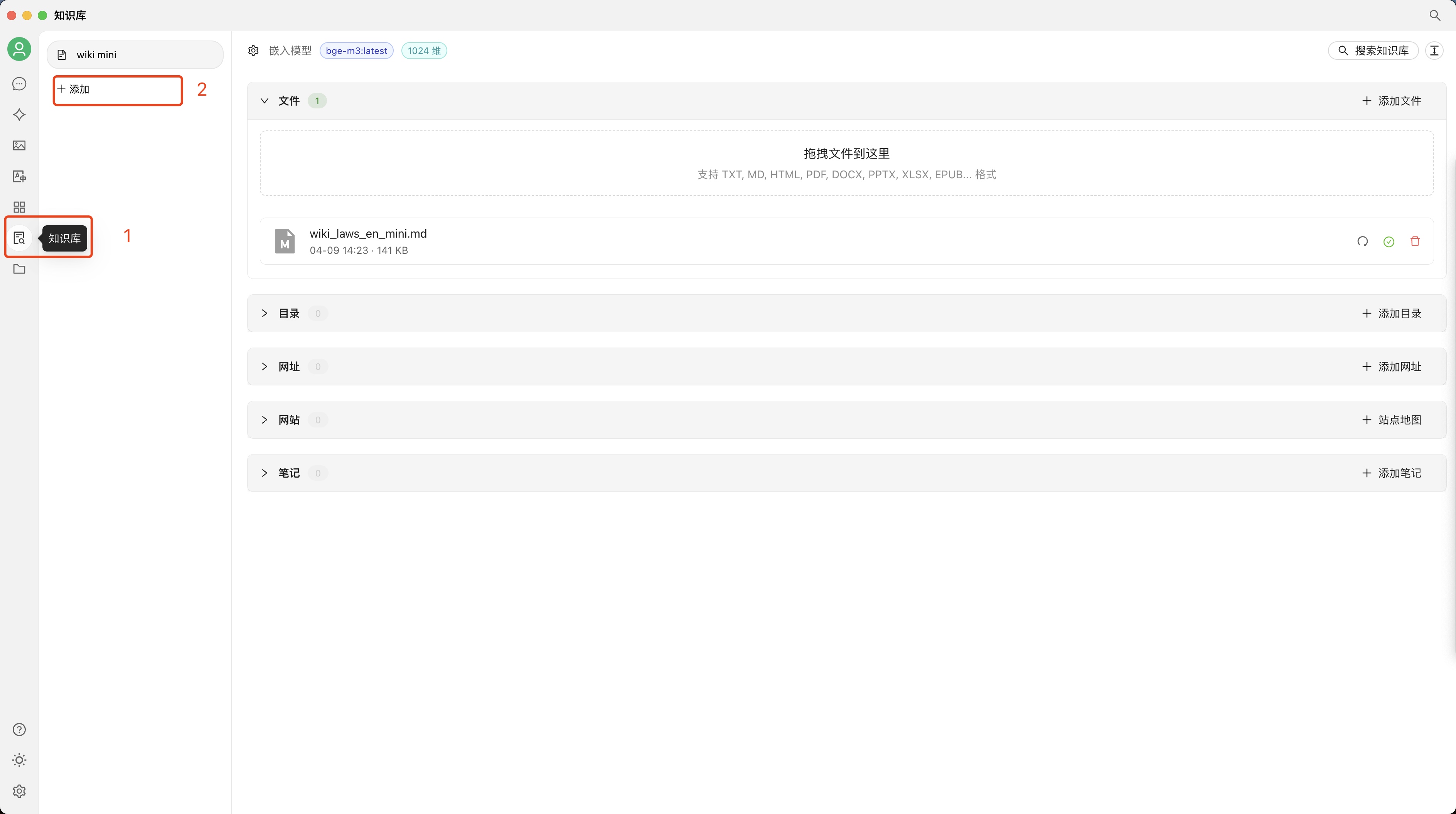

导入文档到知识库

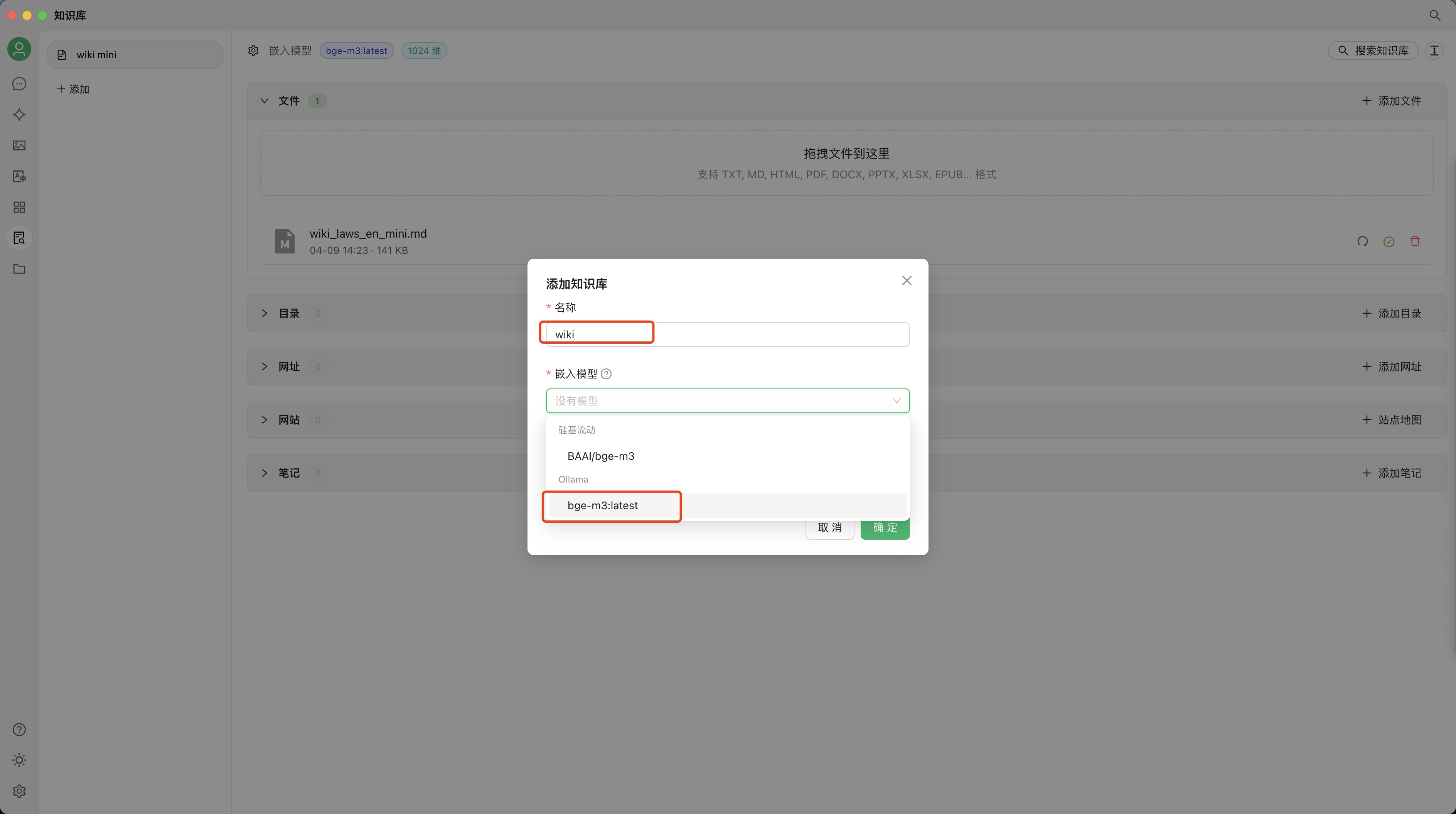

建立一个知识库

选择上面设置的 Ollama - bge-m3 嵌入模型

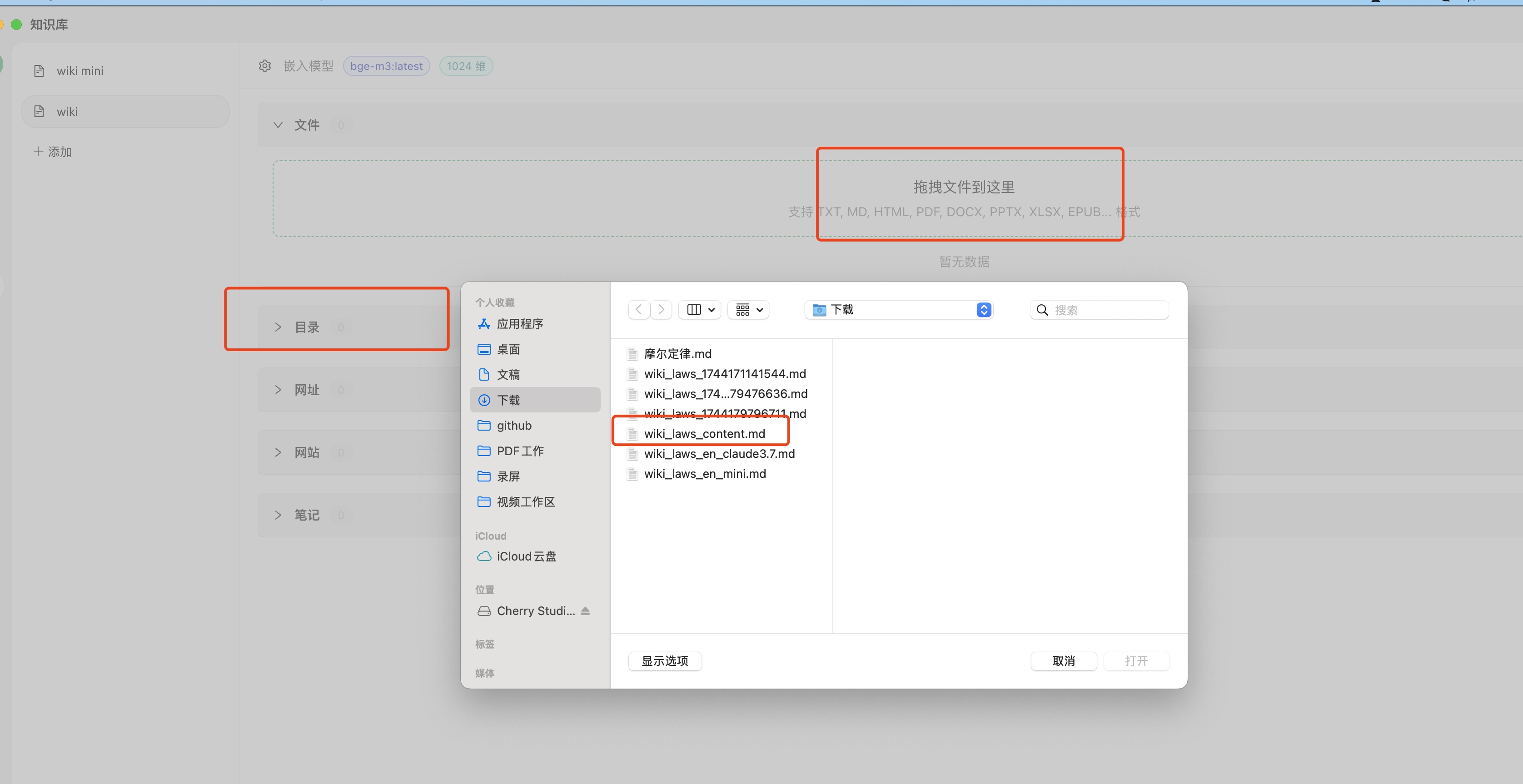

丢文档进去

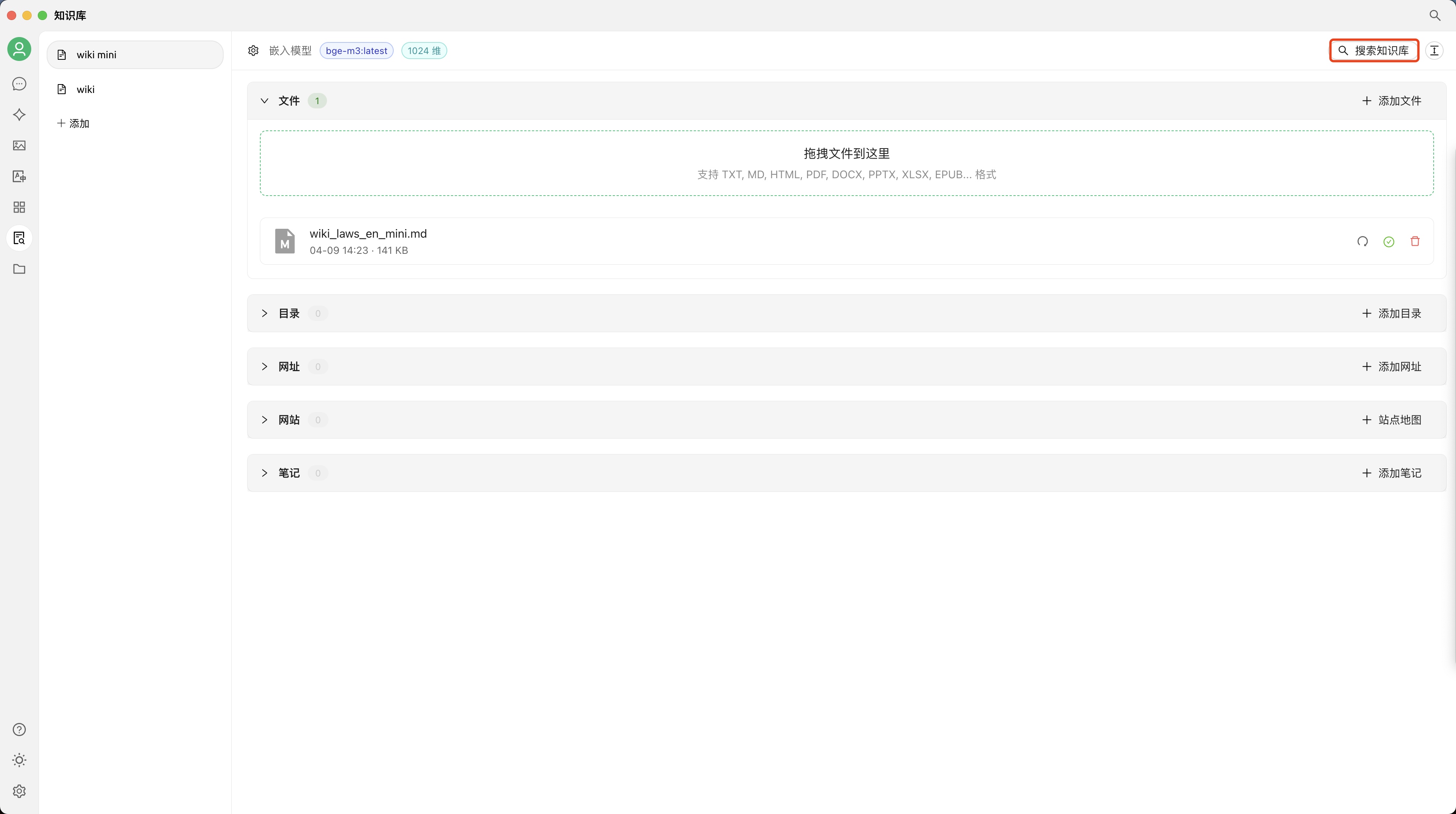

等文档识别完成,就可以提问(注意文档右边是否变绿了

你可检查一下知识库:

给大模型配备知识库提问吧

现在任意一个对话,都可以自己选择是否使用知识库

开始尽情使用吧 🎉

结语

最后这是赛博程序员赵师傅给你整理的干货,如果觉得还不错,可以顺手点个关注~

更多干货欢迎加入星球,提供最新鲜的 AI 趋势,总结最佳实践经验,让AI成为你的超级生产力引擎!解放90%重复劳动,让创意与效率同时爆炸!🚀